Программно-определяемые хранилища (SDS): архитектура и внедрение

- Развод с железом: почему софт побеждает хард

- Архитектура без границ: как устроен программный storage

- Гиперконвергенция: когда SDS становится основой всего

- Экономика вопроса: сколько можно сэкономить

- Ceph, vSAN и другие: кто есть кто в мире SDS

- Подводные камни внедрения: честно о сложностях

- Безопасность и управление: не всё так просто

- Будущее storage: куда движется индустрия

Вы когда-нибудь покупали принтер за копейки, а потом выясняли, что картриджи стоят как половина нового принтера? С традиционными системами хранения данных происходит примерно то же самое, только масштаб другой. Купили СХД за миллионы — добро пожаловать в клуб пожизненных клиентов вендора. Нужны дополнительные диски? Только наши, фирменные, с наценкой 300%. Хотите апгрейд контроллера? Это будет стоить как небольшой дата-центр. И вот на этом фоне появляются программно-определяемые хранилища — технология, которая разрывает порочный круг зависимости от железа.

Развод с железом: почему софт побеждает хард

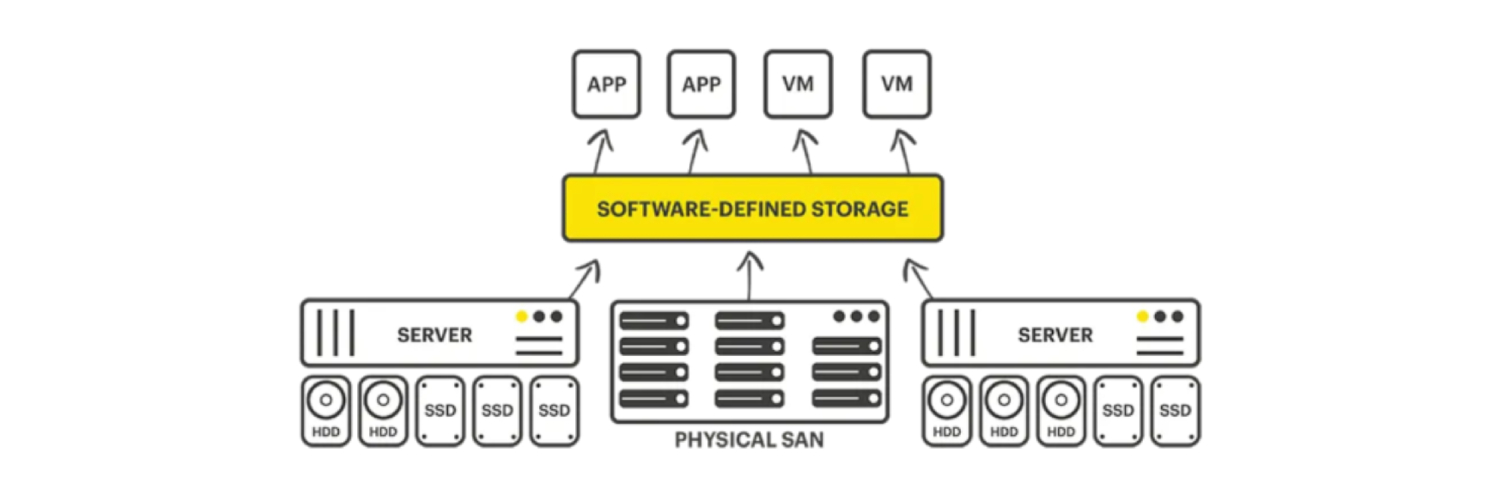

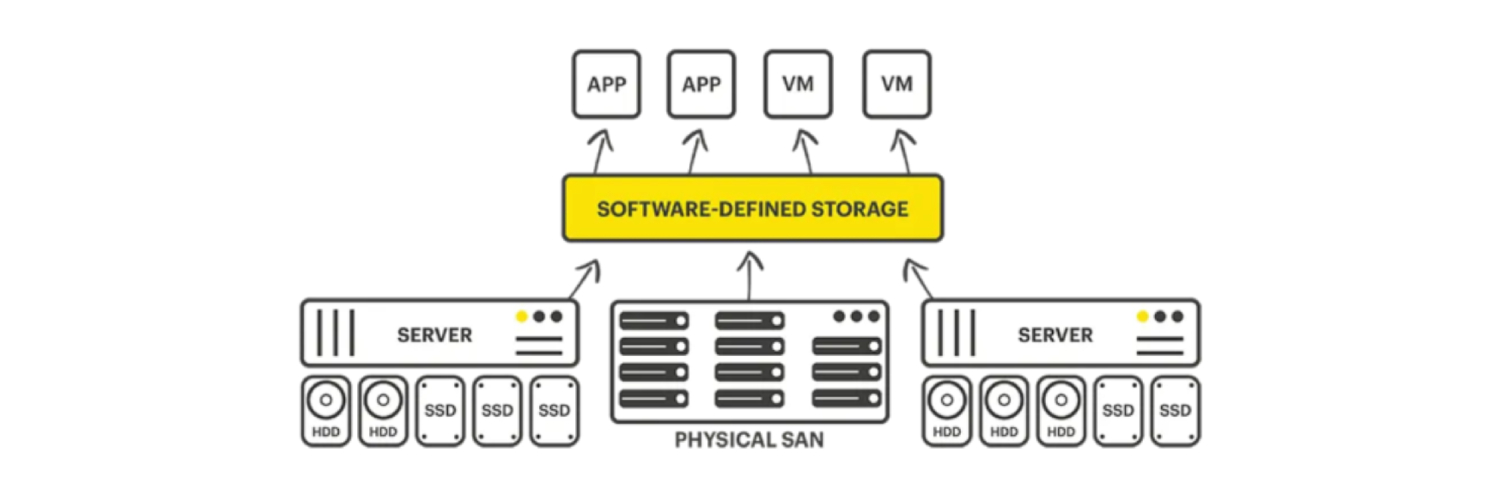

Software defined storage — это не просто модное словосочетание для презентаций. Это фундаментальный сдвиг в философии построения систем хранения. Представьте, что вместо покупки готового монолитного комбайна вы собираете систему из обычных серверов, как конструктор LEGO. Берёте стандартные x86-серверы (или даже ARM, если хочется экзотики), накидываете в них диски, устанавливаете специальное ПО — и вуаля, у вас enterprise-класса хранилище.

Магия происходит на программном уровне. SDS-платформа берёт разрозненные диски из разных серверов и превращает их в единый пул хранения. Для приложений это выглядит как обычная СХД — те же LUN-ы, те же протоколы доступа. Но под капотом — принципиально другая механика.

Ключевое отличие от традиционных систем — полное отделение логики управления от железа. В классической СХД интеллект зашит в проприетарные контроллеры. Сломался контроллер — меняйте на точно такой же, других вариантов нет. В SDS вся логика живёт в софте. Сервер устарел? Заменили на любой другой x86, перенесли диски, подняли софт — работаем дальше.

Это как разница между iPhone и Android. В первом случае вы покупаете готовую экосистему, где всё красиво работает, но шаг влево-вправо невозможен. Во втором — свобода выбора железа, но нужно понимать, что делаешь.

Архитектура без границ: как устроен программный storage

Типичная архитектура SDS выглядит элегантно просто. В основе — обычные серверы, объединённые быстрой сетью. В каждом сервере — процессор, память, диски. Никаких специализированных RAID-контроллеров, кастомных плат, проприетарных шин. Чистый commodity hardware, который можно купить у любого поставщика.

На этом железе разворачивается программный слой, который делает всю магию. Он объединяет локальные диски всех серверов в единое пространство, распределяет данные для отказоустойчивости, управляет репликацией и доступом. По сути, это распределённая операционная система для данных.

Современные SDS-платформы научились выжимать максимум из нового железа. Поддержка NVMe через PCIe даёт скорости, о которых традиционные СХД могут только мечтать. Прямой доступ к накопителям без промежуточных контроллеров снижает задержки до микросекунд. А возможность использовать память сервера как кэш первого уровня делает горячие данные молниеносно доступными.

Масштабирование в SDS происходит естественно. Нужно больше места? Добавили сервер с дисками в кластер, система автоматически перебалансировала данные. Нужно больше производительности? Добавили серверы с NVMe. Всё происходит на лету, без остановки сервисов.

Что особенно красиво — можно миксовать разное железо. Старые серверы с HDD для холодных данных, новые с NVMe для горячих. SDS сама разберётся, что где хранить, основываясь на политиках и паттернах доступа.

Гиперконвергенция: когда SDS становится основой всего

Программно-определяемые хранилища стали фундаментом для гиперконвергентных инфраструктур (HCI). Идея простая: если мы уже virtualizing storage, почему бы не виртуализировать всё остальное на тех же серверах?

В HCI-системах одни и те же физические серверы предоставляют и вычислительные ресурсы (через гипервизор), и хранение (через SDS), и часто даже сеть (через SDN). Получается эдакий IT-комбайн, где всё управляется из единой консоли.

VMware vSAN — классический пример. Берёте несколько ESXi-хостов, включаете vSAN — и локальные диски серверов превращаются в общее хранилище для всех виртуальных машин. Никаких внешних СХД, FC-фабрик, сложных схем подключения. Всё работает через обычную Ethernet-сеть.

Microsoft не отстаёт с Storage Spaces Direct. Технология интегрирована прямо в Windows Server, превращая группу серверов в отказоустойчивое хранилище. Особенно интересно для тех, кто уже живёт в экосистеме Microsoft — не нужно изучать новые инструменты.

Nutanix пошли ещё дальше, создав полноценную облачную платформу на базе HCI. Их решение абстрагирует не только storage, но и всю инфраструктуру, предоставляя AWS-подобный опыт в собственном дата-центре.

Экономика вопроса: сколько можно сэкономить

Давайте о деньгах. Традиционная СХД среднего уровня стоит от 100 тысяч долларов. Это только начальная конфигурация. Добавьте сюда ежегодную поддержку (15-20% от стоимости), апгрейды, дополнительные полки. За пять лет эксплуатации сумма удваивается.

С SDS картина другая. Берём три сервера по 20 тысяч каждый, добавляем диски ещё на 20 тысяч, покупаем лицензии SDS-платформы. Итого около 80 тысяч за решение с сопоставимыми характеристиками. Но главная экономия не в начальных затратах.

Когда через два года понадобится расширение, вы просто покупаете ещё один сервер за 20 тысяч. В традиционной СХД апгрейд обойдётся в 50-70 тысяч минимум. Сломался сервер? Заменили на любой аналогичный. В традиционной СХД замена контроллера — это отдельная эпопея с простоями и рисками.

Но есть и скрытые затраты. SDS требует более квалифицированного персонала. Если для управления традиционной СХД достаточно прочитать мануал вендора, то SDS требует понимания распределённых систем, сетей, виртуализации. Зарплаты таких специалистов выше.

Ceph, vSAN и другие: кто есть кто в мире SDS

Ceph — open source монстр в мире SDS. Поддерживает блочное, файловое и объектное хранение. Используется в OpenStack, работает в продакшене у CERN (да, того самого, с адронным коллайдером). Бесплатный, но требует глубокой экспертизы. Настройка Ceph — это отдельное искусство, освоить которое дано не каждому.

VMware vSAN — выбор для тех, кто уже использует vSphere. Интеграция настолько плотная, что вы можете не заметить, что используете SDS. Работает из коробки, минимум настроек. Но и vendor lock-in никуда не делся, просто теперь вы зависите от VMware, а не от производителя железа.

Microsoft Storage Spaces Direct хорош для Windows-окружений. Если у вас Hyper-V и Windows Server, S2D может стать логичным выбором. Плюс — глубокая интеграция с экосистемой Microsoft. Минус — только Windows, только Hyper-V.

GlusterFS и ZFS — варианты для тех, кто любит open source и готов повозиться. Мощные, гибкие, но требуют серьёзной подготовки. Коммерческая поддержка есть, но это уже другие деньги.

Подводные камни внедрения: честно о сложностях

Переход на SDS — это не просто установка софта. Это изменение всей парадигмы работы с данными. И тут начинаются сюрпризы.

Первая проблема — сеть. SDS генерирует огромный трафик между узлами. Репликация, ребалансировка, восстановление после сбоев — всё это гоняет терабайты по сети. 10 Гбит/с — минимум, 25-40 Гбит/с — оптимально. А это новые свитчи, новые сетевые карты, новая кабельная инфраструктура.

Вторая — планирование ёмкости. В традиционной СХД вы точно знаете, сколько места доступно. В SDS нужно учитывать оверхед на репликацию, метаданные, резерв для ребалансировки. Реально доступно обычно 60-70% от raw capacity.

Третья — troubleshooting. Когда что-то идёт не так в традиционной СХД, вы звоните вендору. В SDS вы должны сами разбираться, почему упала производительность, куда делось место, почему не работает репликация. Да, есть коммерческая поддержка, но она не заменит понимания технологии.

Безопасность и управление: не всё так просто

SDS предоставляет богатые возможности для защиты данных. Репликация, снапшоты, дедупликация, шифрование — всё это есть. Но настраивать и управлять этим придётся самостоятельно.

Распределённая природа SDS создаёт новые векторы атак. Если в традиционной СХД достаточно защитить два контроллера, то в SDS каждый сервер — потенциальная точка входа. Нужна сегментация сети, шифрование трафика между узлами, строгий контроль доступа.

Резервное копирование SDS — отдельная головная боль. Нельзя просто снять снапшот с LUN. Нужно понимать, как данные распределены по кластеру, как обеспечить консистентность при бэкапе, как восстановить данные при полной потере кластера.

Будущее storage: куда движется индустрия

SDS — это только начало. Следующий шаг — интеграция с искусственным интеллектом для предиктивной аналитики и автоматической оптимизации. Системы будут сами решать, где размещать данные, когда делать репликацию, как балансировать нагрузку.

Контейнеризация меняет требования к storage. Kubernetes native storage решения, как Rook или OpenEBS, адаптируют SDS под новые реалии. Persistent volumes для контейнеров, динамическое выделение ресурсов, storage classes — это новый язык, который придётся учить.

Edge computing создаёт спрос на лёгкие SDS-решения, работающие на минимальном железе. Три Raspberry Pi в качестве отказоустойчивого хранилища? Почему бы и нет, если софт это поддерживает.

Программно-определяемые хранилища — это не временный тренд, а фундаментальный сдвиг в подходе к хранению данных. Да, технология требует новых компетенций и несёт дополнительные риски. Но свобода от vendor lock-in, гибкость масштабирования и экономическая эффективность делают SDS неизбежным выбором для современной инфраструктуры. Вопрос не в том, переходить ли на SDS, а в том, когда и как это сделать правильно. И чем раньше вы начнёте изучать эту технологию, тем проще будет адаптироваться к новой реальности, где софт определяет всё.