Протоколы доступа к данным в СХД: iSCSI, Fibre Channel, NFS и SMB

Вы когда-нибудь задумывались, почему протокол NFS, созданный в 1984 году, до сих пор живее всех живых? Или почему компании готовы переплачивать за Fibre Channel, когда есть более доступные альтернативы? Выбор протокола для системы хранения данных — это как выбор транспорта для грузоперевозок. Можно на Ferrari, можно на КамАЗе, а можно и на обычной Газели. Вопрос в том, что именно вы везете и куда.

Блочные против файловых: фундаментальная разница

Прежде чем погружаться в детали каждого протокола, разберемся с базовой концепцией. Протоколы СХД делятся на два лагеря: блочные и файловые.

Блочные протоколы (iSCSI и Fibre Channel) работают с данными как с набором блоков фиксированного размера. Операционная система видит подключенное хранилище как локальный диск — можете форматировать его в любую файловую систему, создавать разделы, делать что угодно. Это как получить участок земли — стройте на нем что хотите.

Файловые протоколы (NFS и SMB) предоставляют готовую файловую систему. Вы работаете с файлами и папками, которые уже организованы на стороне хранилища. Это больше похоже на аренду готового офиса — мебель уже расставлена, просто приносите свои документы.

iSCSI: демократичный подход к блочному хранению

Internet Small Computer System Interface звучит сложно, но суть проста — это SCSI-команды, упакованные в IP-пакеты. Представьте, что вы отправляете посылку обычной почтой вместо курьерской службы. Дешевле? Да. Медленнее? Не всегда.

iSCSI работает поверх обычной Ethernet-сети. Никакого специального оборудования не нужно — достаточно стандартных сетевых карт и коммутаторов. Это делает протокол невероятно гибким. Нужно подключить новый сервер к СХД? Просто настройте iSCSI-инициатор, пропишите target, и готово.

Скорость передачи данных напрямую зависит от вашей сети. На гигабитном Ethernet получите около 100 МБ/с, на 10-гигабитном — до 1,2 ГБ/с. Но есть нюанс: CPU придется обрабатывать весь сетевой трафик. При высоких нагрузках это может стать узким местом. Хотя современные HBA с поддержкой iSCSI Offload Engine решают эту проблему, перекладывая обработку на специализированный чип.

Задержки у iSCSI выше, чем у Fibre Channel — обычно 0,5-1 мс против 0,1-0,2 мс. Для большинства приложений разница незаметна, но базы данных с интенсивным вводом-выводом могут почувствовать.

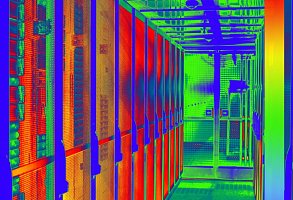

Fibre Channel: формула-1 в мире протоколов

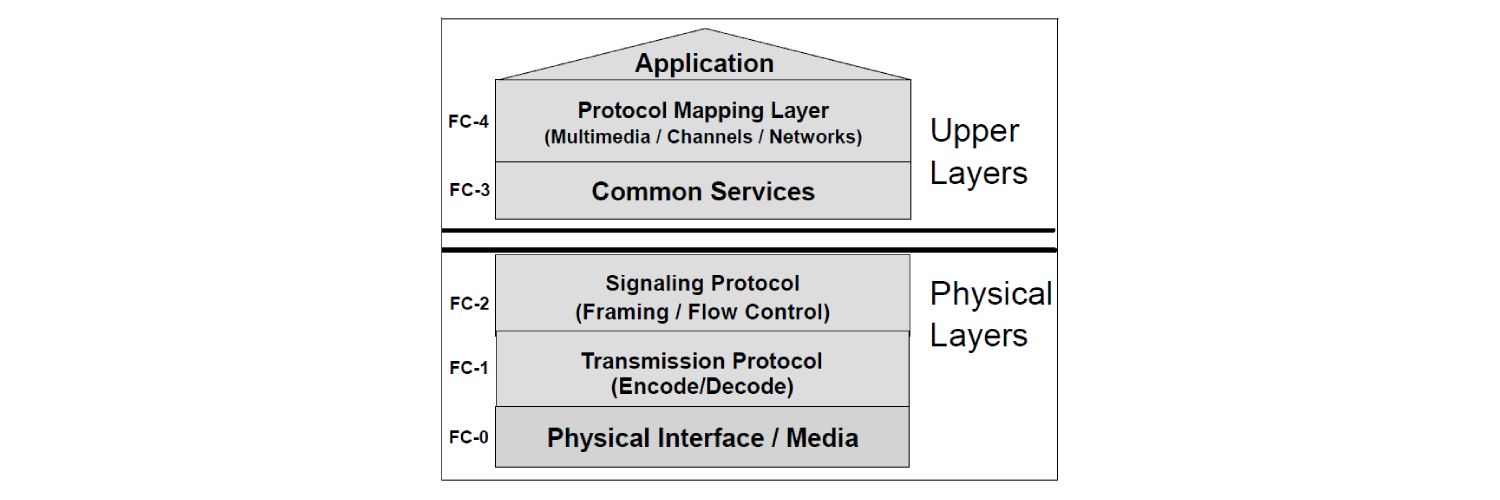

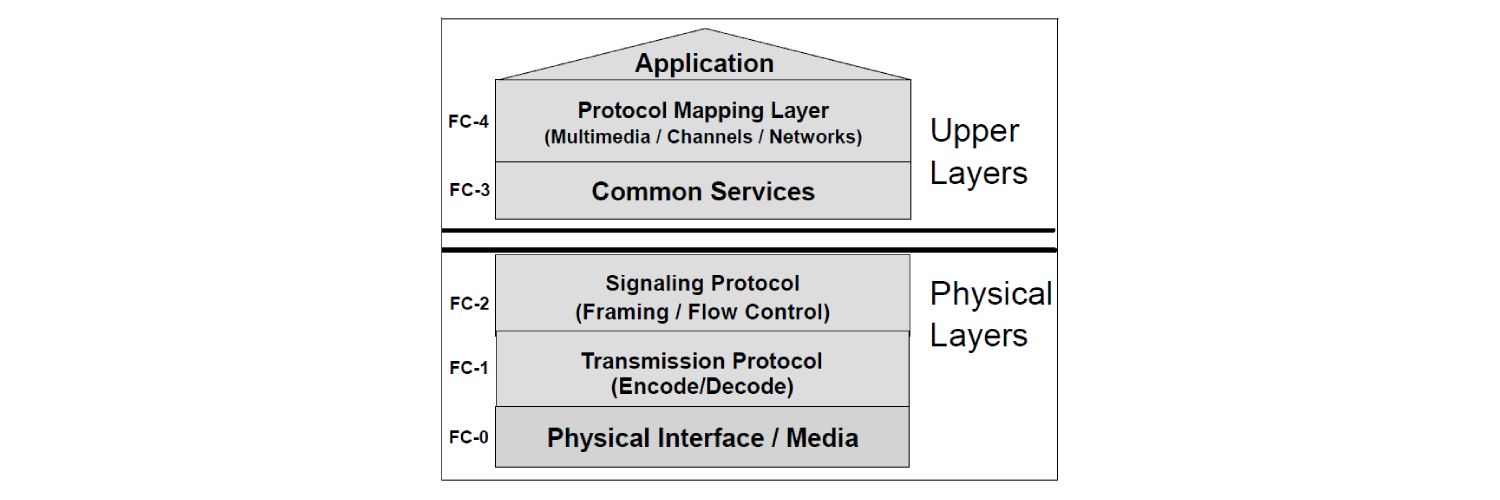

Fibre Channel создавался специально для СХД, и это чувствуется. Протокол работает на уровне 2 модели OSI, минуя все накладные расходы TCP/IP. Данные летят по выделенной SAN-сети со скоростью 8, 16, 32 или даже 128 Гбит/с.

Главное преимущество — предсказуемость. FC гарантирует доставку данных в правильном порядке без потерь. Никаких пересылок, никаких таймаутов. Для критически важных приложений это бесценно.

Но за все приходится платить. HBA-адаптеры стоят от $500 за порт, FC-коммутаторы — от $10,000 за устройство начального уровня. Плюс нужны специальные знания для настройки зонирования, многопутевого ввода-вывода, управления fabric.

| Параметр | iSCSI | Fibre Channel |

|---|---|---|

| Скорость | 1-100 Гбит/с | 8-128 Гбит/с |

| Задержка | 0,5-1 мс | 0,1-0,2 мс |

| Стоимость порта | 5000-20000 | 50000-200000 |

| Сложность настройки | Низкая | Высокая |

| Масштабируемость | Отличная | Хорошая |

NFS: Unix-way в чистом виде

Network File System — детище Sun Microsystems, воплощение философии Unix: делай одну вещь, но делай её хорошо. NFS предоставляет доступ к файлам по сети. Точка.

Протокол настолько прост, что его поддержка встроена в ядро Linux. Монтируете удаленную директорию как локальную, и работаете с файлами обычными командами. Никаких драйверов, никаких специальных утилит.

mount -t nfs storage.company.local:/data /mnt/storage

Вот и вся настройка. Серьезно.

NFS версии 3 до сих пор популярен благодаря стабильности и простоте. Версия 4 добавила безопасность через Kerberos, делегирование блокировок, составные операции для снижения задержек. А NFSv4.2 умеет клонировать файлы на стороне сервера, экономя трафик.

Производительность NFS сильно зависит от размера операций. На больших последовательных чтениях протокол показывает отличные результаты — до 90% от пропускной способности сети. Но множество мелких операций могут создать проблемы из-за синхронной природы протокола.

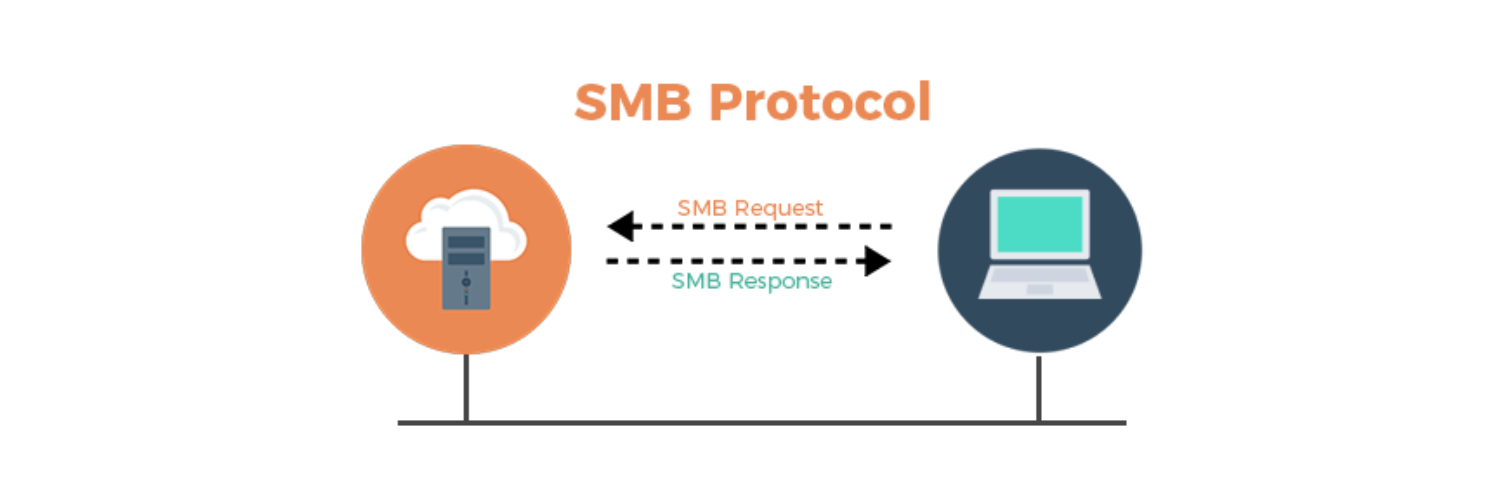

SMB: эволюция от простого к сложному

Server Message Block начинался как способ расшарить принтер в офисе. Сегодня SMB 3.0 — это мощный протокол с шифрованием, многоканальностью и прямым доступом к памяти через RDMA.

Microsoft серьезно поработала над производительностью. SMB Direct использует RDMA для передачи данных в обход процессора — задержки падают до микросекунд, пропускная способность упирается в физические лимиты оборудования. SMB Multichannel автоматически распределяет трафик по нескольким сетевым путям, повышая и скорость, и отказоустойчивость.

Интересная особенность SMB 3.0 — прозрачная отработка отказов. Если сервер падает, клиенты автоматически переподключаются к резервному узлу без потери данных. Приложения даже не замечают сбоя.

Практические сценарии: что и когда выбирать

Виртуализация VMware vSphere? Классический выбор — iSCSI или Fibre Channel для datastores, NFS для ISO-образов и шаблонов. FC дает максимальную производительность для требовательных VM, iSCSI — золотую середину, NFS упрощает управление.

Hyper-V кластер? SMB 3.0 — родной протокол для Hyper-V. Microsoft оптимизировала стек специально для виртуализации. Можно хранить VHD-диски прямо на SMB-шарах с производительностью блочного доступа.

Базы данных? Тут компромиссов быть не может. Oracle RAC требует блочный доступ — выбирайте между iSCSI и FC в зависимости от бюджета. SQL Server одинаково хорошо работает и с блочными протоколами, и с SMB 3.0.

Файловые архивы и бэкапы? NFS или SMB, без вариантов. Блочные протоколы для таких задач — как забивать гвозди микроскопом.

Медиа-продакшн? NFS традиционно доминирует в этой области. Возможность одновременного доступа множества клиентов к одним и тем же файлам критична для совместной работы над видео.

Тенденции и будущее протоколов

Граница между блочными и файловыми протоколами размывается. NVMe over Fabrics обещает задержки в десятки микросекунд — это в 10 раз быстрее текущего FC. Протокол работает поверх Ethernet, InfiniBand или Fibre Channel, объединяя преимущества разных транспортов.

Объектные хранилища постепенно отбирают долю рынка у традиционных протоколов. S3 API стал де-факто стандартом для облачных хранилищ. Многие СХД уже поддерживают объектный доступ наряду с блочным и файловым.

Конвергентные инфраструктуры меняют подход к выбору протоколов. Когда вычисления и хранение объединены в одном устройстве, внешние протоколы становятся менее важными. Данные передаются по внутренней шине, минуя сетевой стек.

Выбор протокола для СХД — это не техническое, а бизнес-решение. iSCSI vs Fibre Channel, NFS против SMB — каждый протокол решает определенные задачи. FC остается королем производительности и надежности, но цена кусается. iSCSI democratизирует блочный доступ, делая SAN доступным для среднего бизнеса. NFS продолжает править в Unix-мире благодаря простоте и отработанности. SMB эволюционировал в универсальный протокол, одинаково хорошо работающий и для файловых шар, и для хранилищ виртуальных машин.

Не существует универсально правильного выбора. Зато есть правильный выбор для вашей конкретной задачи, бюджета и уровня экспертизы команды. Протоколы схд продолжат развиваться, но базовые принципы останутся неизменными: блочный доступ для полного контроля, файловый — для удобства совместной работы. А может, через пару лет эта дилемма вообще потеряет смысл — NVMe over Fabrics и объектные хранилища изменят правила игры. Время покажет.