Высоконагруженные системы и Highload: комплексное руководство по архитектуре и масштабированию

Представьте секунду, когда ваш онлайн-магазин падает в Черную пятницу. Каждая минута простоя — это тысячи потерянных клиентов и миллионы упущенной выручки. Именно для таких моментов существуют высоконагруженные системы — технологический щит между вашим бизнесом и хаосом пиковых нагрузок.

Почему обычная архитектура ломается под нагрузкой

Традиционные системы проектируются для среднестатистической нагрузки. Вы арендуете сервер, настраиваете базу данных, запускаете приложение — и все работает. Пока не приходят тысячи пользователей одновременно. Тогда база начинает тормозить, процессор загружается на 100%, а очередь запросов растет быстрее, чем система успевает их обрабатывать.

Высоконагруженные системы решают эту проблему кардинально иначе. Вместо попыток выжать максимум из одного мощного сервера, они распределяют нагрузку между десятками или сотнями узлов. Если один компонент выходит из строя, остальные продолжают работать. Система становится похожа на организм, где отказ одной клетки не приводит к смерти всего тела.

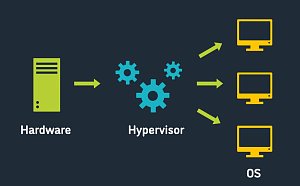

Ключевое отличие highload-архитектуры — тесная интеграция железа и софта. Программное обеспечение должно понимать возможности оборудования и эффективно их использовать. А железо подбирается под конкретные задачи: быстрые SSD для баз данных, мощные GPU для обработки видео, специализированные сетевые карты для балансировки трафика.

Архитектурные паттерны, которые спасают от краха

Современная высоконагруженная система строится по принципу микросервисной архитектуры. Вместо монолитного приложения вы получаете набор независимых сервисов, каждый из которых отвечает за свою функцию. Сервис авторизации, сервис обработки платежей, сервис рекомендаций — все работают параллельно и общаются через API.

Разделение фронтенда и бэкенда позволяет масштабировать их независимо. Статические файлы раздаются через CDN, динамический контент генерируется на бэкенд-серверах, а между ними стоит балансировщик нагрузки, который распределяет запросы равномерно.

| Компонент системы | Роль в архитектуре | Типичное железо |

|---|---|---|

| Балансировщик | Распределение трафика | Специализированные устройства или виртуальные машины |

| Кэш-серверы | Ускорение доступа к данным | Серверы с большим объемом RAM |

| База данных | Хранение основных данных | Серверы с быстрыми SSD/NVMe |

| Очереди сообщений | Асинхронная обработка | Стандартные серверы среднего класса |

Кэширование — это первая линия обороны против высоких нагрузок. Часто запрашиваемые данные хранятся в оперативной памяти, откуда достаются за микросекунды. Redis или Memcached способны обрабатывать миллионы запросов в секунду на правильно настроенном железе.

Службы очередей типа RabbitMQ или Apache Kafka позволяют системе дышать. Вместо синхронной обработки каждого запроса, вы складываете задачи в очередь и обрабатываете их по мере возможности. Пользователь отправил заказ — он сразу получает подтверждение, а фактическая обработка происходит асинхронно.

Масштабирование: искусство роста без боли

Горизонтальное масштабирование стало стандартом де-факто для highload-систем. Добавить новый сервер в кластер проще и дешевле, чем апгрейдить существующий до топовой конфигурации. Особенно это заметно в облачных средах, где новые инстансы запускаются за минуты.

Но не все компоненты одинаково хорошо масштабируются горизонтально. Базы данных, например, требуют особого подхода. Репликация помогает распределить нагрузку по чтению, но запись все равно идет в мастер-узел. Здесь на помощь приходит шардирование — разделение данных на независимые части, каждая со своим мастером.

Динамическое масштабирование позволяет системе адаптироваться к изменениям нагрузки автоматически. Утром, когда все проверяют почту, система разворачивает дополнительные инстансы. Ночью, когда активность падает, лишние серверы отключаются для экономии ресурсов.

Мониторинг и тестирование: предупрежден — значит вооружен

Высоконагруженная система без мониторинга — это бомба замедленного действия. Вы должны знать состояние каждого компонента в реальном времени: загрузку процессоров, использование памяти, скорость ответа баз данных, длину очередей.

Современные инструменты мониторинга не просто собирают метрики, но и предсказывают проблемы. Машинное обучение анализирует паттерны и предупреждает о возможных сбоях заранее. Prometheus с Grafana стали стандартным стеком для визуализации метрик, а ELK (Elasticsearch, Logstash, Kibana) помогает анализировать логи.

Нагрузочное тестирование должно стать регулярной практикой. Инструменты вроде Apache JMeter или Gatling симулируют тысячи пользователей и показывают, где система начинает проседать. Тестирование хаоса (chaos engineering) идет дальше — специально ломает компоненты в продакшене, чтобы проверить устойчивость системы.

Безопасность в условиях высоких нагрузок

DDoS-атаки часто маскируются под обычные пики нагрузки. Различить их помогает анализ поведения: настоящие пользователи действуют разнообразно, боты — однообразно. Специализированные решения типа Cloudflare или собственные системы фильтрации должны работать на уровне сети, не допуская вредоносный трафик до приложения.

Безопасность API становится критически важной в микросервисной архитектуре. Каждый сервис долженпроверять аутентификацию и авторизацию запросов. Rate limiting ограничивает количество запросов от одного клиента, защищая от злоупотреблений.

Практические рекомендации по выбору железа

Для баз данных критична скорость дисковой подсистемы. NVMe-накопители дают прирост производительности в разы по сравнению с обычными SSD. Но важно помнить: самый быстрый диск не поможет, если данные не влезают в оперативную память. Поэтому для кэш-серверов приоритет — максимальный объем RAM.

Сетевая инфраструктура часто становится узким местом. 10-гигабитные сетевые карты — минимум для серверов в highload-системе. А для балансировщиков и маршрутизаторов может потребоваться 40 или даже 100 Гбит/с.

Процессоры выбираются исходя из характера нагрузки. Для веб-серверов важнее количество ядер, для баз данных — частота и размер кэша. Современные процессоры AMD EPYC или Intel Xeon Scalable предлагают оптимальный баланс для большинства задач.

Высоконагруженные системы продолжают эволюционировать. Serverless-архитектуры обещают автоматическое масштабирование без управления серверами. Edge computing приближает вычисления к пользователям, снижая задержки. Квантовые вычисления могут революционизировать обработку больших данных.

Но какие бы технологии ни появлялись, основные принципы остаются неизменными: распределение нагрузки, отказоустойчивость, мониторинг и постоянная оптимизация. Высоконагруженная система — это не набор технологий, а философия проектирования, где каждый компонент готов к худшему сценарию, но работает для лучшего результата.