Жидкостное охлаждение процессоров и GPU в серверах: типы и установка

- Почему вода побеждает воздух

- Три пути к прохладе: типы систем

- Замкнутые контуры — классика жанра

- Иммерсионное охлаждение — радикальный подход

- Гибридные системы — компромисс для переходного периода

- Установка: от теории к практике

- Технология "горячей воды" — парадокс эффективности

- Обслуживание: цена холодной головы

- Реальные применения и результаты

- Взгляд в будущее холодных вычислений

Представьте серверную комнату, где вместо привычного гула вентиляторов — почти тишина. А процессоры при этом работают на полную мощность, выдавая 400-500 ватт тепла каждый. Фантастика? Нет, это реальность современных дата-центров с жидкостным охлаждением серверов.

В одном из крупнейших суперкомпьютерных центров Европы недавно перешли на водяное охлаждение CPU и сэкономили 40% на электричестве. Причем не только на самом охлаждении — производительность систем выросла на 15% просто потому, что процессоры перестали троттлить от перегрева.

Почему вода побеждает воздух

Физика проста и безжалостна: вода проводит тепло в 25 раз лучше воздуха, а ее теплоемкость в 4 раза выше. Это значит, что литр воды может забрать и унести столько же тепла, сколько 3000 литров воздуха. Когда современные GPU потребляют по 700 ватт, а в стойке их десяток — воздух просто сдается.

Но дело не только в физике. Воздушное охлаждение требует огромных объемов для размещения радиаторов и организации воздушных потоков. В итоге половина серверной комнаты работает не на вычисления, а на то, чтобы горячий воздух не смешивался с холодным. Жидкостное охлаждение позволяет разместить в той же стойке в 2-3 раза больше оборудования.

Еще один неочевидный плюс — акустический комфорт. Серверная с воздушным охлаждением звучит как взлетная полоса аэропорта: 80-90 дБ постоянного шума. С жидкостным охлаждением уровень шума падает до 40-50 дБ — можно работать без наушников и не сойти с ума.

Три пути к прохладе: типы систем

Инженеры придумали несколько способов подружить электронику с жидкостью. Каждый со своими особенностями и областями применения.

Замкнутые контуры — классика жанра

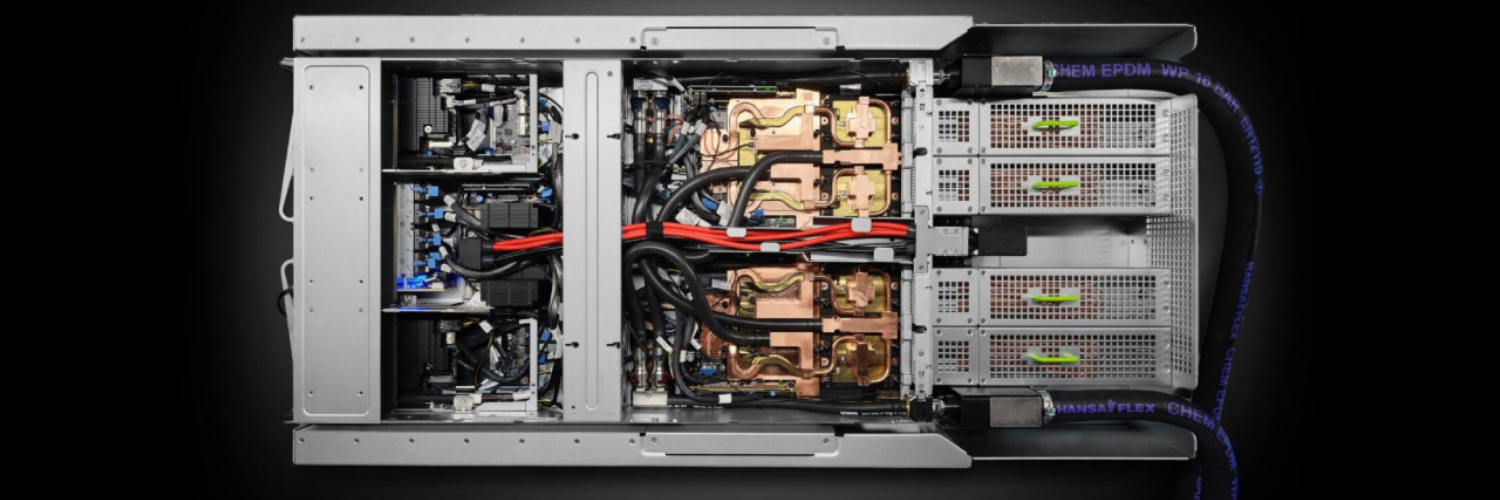

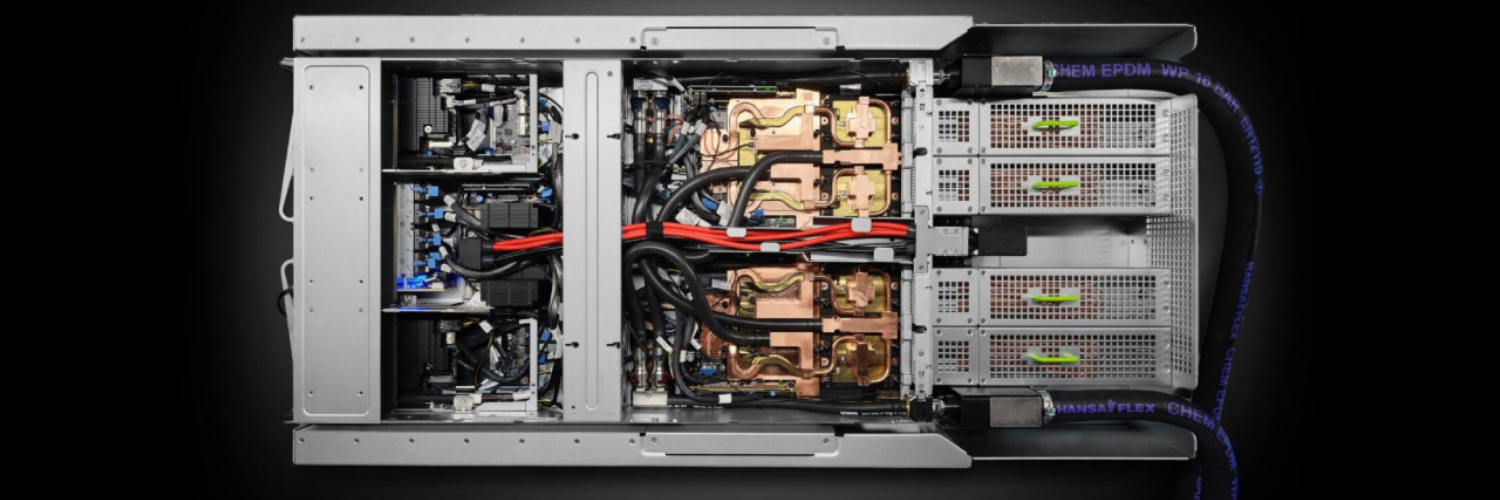

Это то, что вы видели в игровых ПК, только масштабированное до промышленных размеров. Специальные водоблоки крепятся прямо на процессоры и GPU, забирая тепло в точке его генерации. Дальше нагретая жидкость по трубкам уходит к радиатору, где охлаждается и возвращается обратно.

В серверном исполнении это выглядит сложнее. Каждая стойка получает подвод холодной воды и отвод горячей. Внутри — разветвленная система трубок с быстросъемными соединениями, чтобы можно было заменить сервер без слива всей системы. Помпы, датчики протечек, резервные контуры — все это превращает простую идею в сложную инженерную систему.

| Характеристика | Замкнутый контур | Традиционное воздушное |

|---|---|---|

| Эффективность охлаждения | До 1000 Вт с процессора | До 300 Вт с процессора |

| Уровень шума | 40-50 дБ | 80-90 дБ |

| Плотность размещения | Высокая | Средняя |

| Сложность обслуживания | Высокая | Низкая |

| Первоначальные затраты | Высокие | Средние |

| Эксплуатационные расходы | Низкие | Высокие |

Иммерсионное охлаждение — радикальный подход

А что если просто утопить сервер в жидкости целиком? Звучит безумно, но работает превосходно. Серверы погружают в ванны с диэлектрической жидкостью — специальным маслом, которое не проводит электричество. Компоненты буквально купаются в охладителе.

Преимущества иммерсионного охлаждения впечатляют. Во-первых, охлаждаются абсолютно все компоненты — не только процессоры и GPU, но и память, диски, чипсеты, элементы питания. Во-вторых, можно забыть про вентиляторы вообще. В-третьих, плотность размещения оборудования достигает космических значений — компоненты можно располагать вплотную друг к другу.

Есть два варианта иммерсионного охлаждения. Однофазное, где жидкость остается жидкостью, просто циркулирует и охлаждается во внешнем теплообменнике. И двухфазное, где специальная жидкость кипит прямо на горячих компонентах при температуре 50-60°C, пар поднимается вверх, конденсируется на холодной крышке и стекает обратно. Второй вариант эффективнее, но требует герметичных емкостей и более дорогих жидкостей.

Гибридные системы — компромисс для переходного периода

Не все готовы сразу нырнуть в мир тотального жидкостного охлаждения. Гибридные системы позволяют охлаждать жидкостью только самые горячие компоненты — процессоры и GPU, оставляя остальное на воздушном охлаждении.

Это разумный компромисс для существующих дата-центров. Можно постепенно переводить самые проблемные стойки на жидкость, не перестраивая всю инфраструктуру. Правда, придется поддерживать две системы охлаждения параллельно, что усложняет эксплуатацию.

Установка: от теории к практике

Монтаж жидкостного охлаждения в серверной — это не просто подключил трубки и забыл. Это комплексный инженерный проект, который начинается задолго до первой капли охладителя.

Сначала нужно подготовить инфраструктуру. Для замкнутых контуров потребуется система подачи охлажденной воды с температурой 15-25°C. Звучит просто, пока не выясняется, что нужна резервная линия, система фильтрации, контроль качества воды (никакой накипи!), датчики протечек по всему маршруту.

Производительность системы рассчитывается исходя из тепловой нагрузки. Современный сервер с парой топовых процессоров и четырьмя GPU может выделять до 3-4 кВт тепла. Умножьте на количество серверов в стойке, добавьте 20% запаса — получите требуемую мощность охлаждения.

Особое внимание — быстроразъемным соединениям. Они должны автоматически перекрывать поток при отключении, чтобы можно было менять серверы без остановки всей системы. Качественные соединения стоят как небольшой сервер, но экономить на них — себе дороже. Одна протечка может положить стойку оборудования за миллионы рублей.

Для иммерсионных систем задачи другие. Нужны специальные ванны из нержавеющей стали или композитных материалов, системы циркуляции и фильтрации диэлектрической жидкости, теплообменники для отвода тепла. И самое дорогое — сама жидкость. Кубометр специального диэлектрического масла может стоить как хороший автомобиль.

Технология "горячей воды" — парадокс эффективности

Казалось бы, чем холоднее охладитель, тем лучше. Но современные системы переворачивают эту логику. Технология "горячей воды" использует теплоноситель с температурой 40-60°C. Процессоры при этом работают при 70-80°C — в пределах нормы.

Зачем это нужно? Горячую воду не нужно специально охлаждать компрессорами и чиллерами. Достаточно простого теплообменника с внешним воздухом или градирни. Экономия на охлаждении воды может достигать 90%. А если поблизости есть потребитель тепла — офисное здание, бассейн, теплицы — можно продавать тепло и превратить расходы в доходы.

Некоторые дата-центры в Северной Европе уже отапливают целые районы городов теплом от серверов. Жители получают дешевое отопление, дата-центр — дополнительный доход и репутацию экологичного бизнеса.

Обслуживание: цена холодной головы

Жидкостное охлаждение серверов требует более квалифицированного обслуживания, чем воздушное. Но не все так страшно, как кажется.

Главный страх — протечки. На практике качественная система с правильными компонентами течет не чаще, чем домашний водопровод. Датчики обнаруживают даже минимальные протечки, а системы автоматического отключения перекрывают подачу воды быстрее, чем жидкость успеет добраться до электроники.

Регулярное обслуживание включает проверку качества охлаждающей жидкости (pH, проводимость, наличие примесей), чистку фильтров, проверку работы помп и датчиков. Раз в год-два может потребоваться частичная замена жидкости в системе. Для иммерсионных систем — периодическая фильтрация масла от частиц, которые неизбежно появляются от трения движущихся частей.

| Операция | Периодичность | Время простоя |

|---|---|---|

| Проверка датчиков | Еженедельно | 0 |

| Анализ качества жидкости | Ежемесячно | 0 |

| Чистка фильтров | Квартально | 0-30 минут |

| Проверка соединений | Раз в полгода | 0 |

| Частичная замена жидкости | Раз в 1-2 года | 2-4 часа |

| Полная замена жидкости | Раз в 3-5 лет | 8-24 часа |

Реальные применения и результаты

Водяное охлаждение CPU уже не экзотика, а стандарт для высокопроизводительных вычислений. Суперкомпьютер Fugaku в Японии, занимавший первое место в рейтинге TOP500, использует водяное охлаждение для своих 7,6 миллионов ядер. Система потребляет 30 МВт электричества, и без жидкостного охлаждения просто расплавилась бы.

Майнинговые фермы массово переходят на иммерсионное охлаждение. При работе 24/7 на максимальной нагрузке экономия на электричестве окупает переход за 12-18 месяцев. Плюс карты живут дольше — нет пыли, окисления, термоциклирования.

Облачные провайдеры экспериментируют с жидкостным охлаждением для edge-вычислений. Компактные серверные модули с иммерсионным охлаждением можно ставить где угодно — от подвалов офисных зданий до морских контейнеров. Не нужна сложная вентиляция, минимальный шум, высокая плотность оборудования.

Взгляд в будущее холодных вычислений

Развитие идет по нескольким направлениям. Появляются новые диэлектрические жидкости на основе фторкетонов — они кипят при 50°C, не токсичны, не разрушают озоновый слой. Правда, пока стоят как космический корабль.

Микроканальное охлаждение обещает еще большую эффективность. Вместо водоблоков — микроскопические каналы прямо в кремниевой подложке процессора. Тепло отводится непосредственно от транзисторов, без промежуточных слоев. IBM уже показывала прототипы с плотностью отвода тепла до 1 кВт с квадратного сантиметра.

Квантовые компьютеры требуют не охлаждения, а криогенной заморозки до температур, близких к абсолютному нулю. Но и тут жидкости — жидкий гелий и азот — играют ключевую роль.

Интересное направление — охлаждение с использованием искусственного интеллекта. Система анализирует нагрузку на серверы, прогнозирует тепловыделение и заранее регулирует потоки охладителя. Экономия может достигать 20% по сравнению с реактивным управлением.

Жидкостное охлаждение серверов — это не просто способ справиться с растущим тепловыделением. Это возможность кардинально изменить подход к проектированию дата-центров. Меньше места, меньше энергии, больше вычислительной мощности. И да, придется научиться не бояться воды рядом с электроникой. Физика на нашей стороне — осталось преодолеть психологический барьер.

Может, через десять лет воздушное охлаждение в серверных будет восприниматься как архаизм. Как сейчас воспринимаются перфокарты или магнитные барабаны. Технологии не стоят на месте, и то, что вчера казалось безумием, завтра становится стандартом индустрии.