Обзор Dell PowerEdge R670: тесты сервера 1U на базе Intel Xeon 6

Когда Dell анонсировала R670, в профильных чатах разгорелся спор: зачем городить петабайт NVMe-хранилища в одном юните? Кто-то крутил пальцем у виска, кто-то молча лез в конфигуратор. Через пару месяцев выяснилось — вторых оказалось значительно больше. Давайте разбираться, почему.

Что за зверь и зачем он нужен

Dell PowerEdge R670 — двухсокетный 1U-сервер, построенный на процессорах Intel Xeon 6. Целевая ниша: задачи с высокой плотностью хранения и вычислений в дата-центрах, где каждый юнит стойки на вес золота. Виртуализация, облачные платформы, программно-определяемые хранилища (SDS), инференс ИИ-моделей — всё это ложится на R670 без компромиссов.

Формально это наследник R660, но разница между поколениями ощущается не как «апгрейд», а как смена парадигмы. Переход на Xeon 6, новый форм-фактор накопителей EDSFF E3.S, собственный чип iDRAC10 — Dell переписала практически всю начинку.

Процессоры: E-ядра, P-ядра и 350 ватт тепла в одном юните

R670 поддерживает до двух процессоров Intel Xeon 6. Здесь выбор между двумя архитектурами:

- Xeon 6 E-core (Sierra Forest) — до 144 E-ядер на сокет. Заточены под throughput-нагрузки: веб-сервисы, микросервисы, контейнеры. Энергоэффективность — главный козырь.

- Xeon 6 P-core (Granite Rapids) — до 86 P-ядер на сокет. Подходят для задач, где важна производительность одного потока: базы данных, виртуализация, ИИ-инференс.

Флагманский Xeon 6767P работает с TDP 350 Вт. Засунуть два таких процессора в 1U и не превратить серверную в баню — задача нетривиальная. Dell решает её комбинацией оптимизированных воздуховодов и опциональным жидкостным охлаждением (Direct Liquid Cooling). Воздушного охлаждения хватает для большинства конфигураций, но при полной загрузке двух 350-ваттных CPU стоит присмотреться к DLC.

Отдельная тема — поведение под нагрузкой. Xeon 6 P-core поддерживает Intel SST (Speed Select Technology), что позволяет выделять ресурсы ядер между профилями: часть ядер работает на повышенной частоте, остальные — в энергосберегающем режиме. Для серверов виртуализации, где часть VM требует высокой тактовой частоты (SQL Server, 1С), а часть обходится минимумом (файловые серверы, DNS) — способ выжать больше из одного хоста без дополнительных затрат.

По SPEC-тестам R670 на Xeon 6 показывает лидирующие результаты в производительности на ватт среди 1U-платформ. Это не маркетинг — если сравнить с предшественником R660 на Xeon Scalable 5-го поколения, прирост в многопоточных задачах достигает 2–2.5x при сопоставимом энергопотреблении. В задачах ИИ-инференса (суммаризация документов, NLP-модели) разница ещё заметнее — AMX-инструкции Xeon 6 дают до 3–5x ускорения на операциях с INT8/BF16 по сравнению со старыми VNNI-инструкциями.

| Параметр | R660 (Xeon 5-gen) | R670 (Xeon 6 P-core) | R670 (Xeon 6 E-core) |

|---|---|---|---|

| Ядер на сокет (макс.) | 64 | 86 | 144 |

| TDP (макс.) | 350 Вт | 350 Вт | 250 Вт |

| Слотов памяти | 32 | 32 | 32 |

| Память (макс.) | 4 ТБ DDR5 | 8 ТБ DDR5 | 8 ТБ DDR5 |

| Скорость памяти | 5600 MT/s | 6400 MT/s | 6400 MT/s |

Память: 8 ТБ DDR5 и зачем столько

32 слота DDR5 с поддержкой до 8 ТБ на скорости 6400 MT/s. Для сервера виртуализации это означает возможность разместить сотни виртуальных машин на одном хосте. Для баз данных — держать горячие данные в оперативке, а не гонять их с накопителей.

Поддерживаются модули RDIMM объёмом от 16 ГБ до 256 ГБ. Если бюджет позволяет — доступны MCRDIMM (Multiplexer Combined RDIMM), которые удваивают ёмкость на канал. Технология свежая и стоит соответственно, но для задач, где каждый гигабайт RAM экономит деньги на СХД, инвестиция окупается.

Любопытный момент с энергопотреблением: в idle DRAM тянет 17–19 Вт на сокет. Вроде немного, но при планировании плотных инсталляций на сотни серверов эти ватты складываются в ощутимые счета за электричество. Для дата-центров с оплатой за киловатт-час — параметр, который стоит закладывать в TCO.

Хранение: петабайт NVMe в одном юните

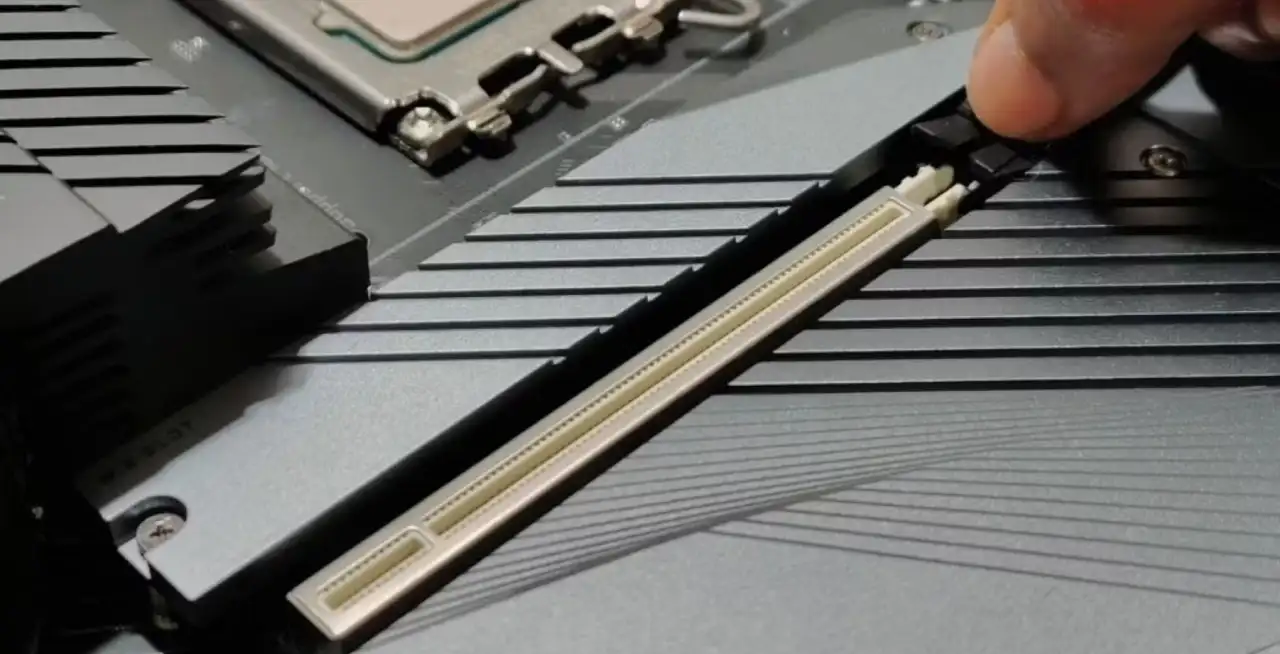

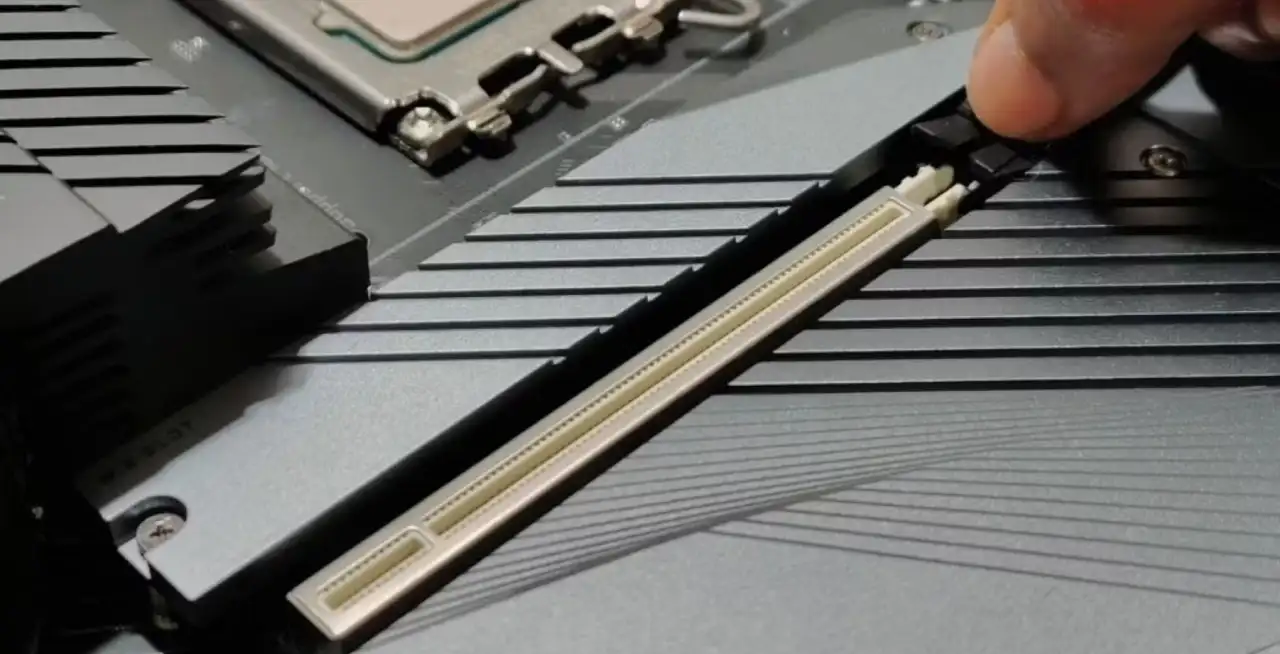

Это, пожалуй, главная «фишка» R670. Сервер поддерживает до 20 отсеков EDSFF E3.S NVMe — тонкий форм-фактор SSD, который приходит на смену U.2. Суммарная ёмкость превышает 1 ПБ в корпусе высотой 1U.

Для RAID доступен контроллер PERC H975i с поддержкой аппаратного RAID 0/1/5/6/10/50/60. Если вы строите SDS-кластер и RAID не нужен — накопители можно прокинуть напрямую в HBA-режиме.

Вот как выглядят возможные конфигурации хранилища:

| Конфигурация | Кол-во дисков | Форм-фактор | Макс. ёмкость |

|---|---|---|---|

| NVMe E3.S | до 20 | EDSFF E3.S | >1 ПБ |

| NVMe 2.5" | до 8 | U.2 | ~122 ТБ |

| SAS/SATA 2.5" | до 8 | SFF | ~61 ТБ |

| Boot (внутр.) | 2 | M.2 BOSS-N1 | 960 ГБ (RAID1) |

Внутренний модуль BOSS-N1 с двумя M.2-накопителями для загрузочного раздела — решение, которое освобождает фронтальные отсеки под рабочие данные. Мелочь, но грамотная. Загрузочный RAID1 на двух M.2 внутри корпуса означает, что смерть одного boot-диска не превращается в ночной аврал — сервер продолжает работать, а замена делается в плановом окне.

Ещё один плюс перехода на E3.S — улучшенный термальный профиль. Тонкий форм-фактор обеспечивает лучший воздушный поток между накопителями, чем U.2. В 1U-корпусе, где каждый миллиметр на счету, это прямо влияет на throttling и срок службы SSD.

iDRAC10: прощайте, F-клавиши

Dell полностью переделала контроллер управления. iDRAC10 работает на собственном чипе Dell (не ASPEED, как у конкурентов), с Kingston eMMC в качестве хранилища прошивки. Это не косметический рестайлинг — архитектура другая. Собственный чип даёт Dell контроль над всем стеком: от железа до firmware. Для безопасности это плюс — меньше зависимость от сторонних компонентов с потенциальными уязвимостями.

Что это даёт в реальной работе:

- Выбор загрузочного устройства без захода в BIOS и нажатия F-клавиш. Настраивается через веб-интерфейс iDRAC или API. Мелочь? Когда у Вас 200 серверов — это экономия часов.

- Телеметрия сенсоров в реальном времени: температуры, энергопотребление, состояние вентиляторов, статус накопителей. Всё доступно через Redfish API.

- Настройка RAID, сетевых интерфейсов, порядка загрузки — из одного интерфейса, без перезагрузок в BIOS Setup.

- Управление флотом серверов через API: массовое обновление прошивок, конфигурирование, мониторинг. Для инфраструктуры с десятками и сотнями узлов — необходимость, а не роскошь.

Интеграция с Dell OpenManage Enterprise позволяет управлять жизненным циклом серверов из единой консоли: от первоначальной настройки до вывода из эксплуатации. Ansible-модули для iDRAC тоже обновлены — автоматизация через Infrastructure as Code работает из коробки.

Сеть и ускорители

Сетевая подсистема построена на PCIe Gen5. Базовая конфигурация включает встроенный сетевой адаптер (OCP 3.0), плюс слоты расширения под дополнительные карты. Доступны варианты от Broadcom и Intel: 10/25/50/100 GbE. Для fabric-подключений к СХД или вычислительному кластеру — карты Mellanox ConnectX-7 с поддержкой InfiniBand HDR/NDR или 200/400 GbE.

Для задач ИИ-инференса и ускоренных вычислений R670 поддерживает до трёх GPU или ускорителей мощностью до 75 Вт каждый в однослотовом форм-факторе. Это не уровень DGX-станции, но для инференса небольших моделей — суммаризации документов, классификации, генерации эмбеддингов — хватает с запасом.

Ограничение по мощности ускорителей (75 Вт на слот) — сознательный компромисс. R670 позиционируется как платформа для плотных вычислений и хранения, а не как GPU-сервер. Если нужны A100/H100 — смотрите в сторону R760xa или R770xa.

Энергоэффективность: считаем ватты

R670 комплектуется блоками питания мощностью 800–2400 Вт с сертификацией 80 PLUS Platinum. Для типовой конфигурации с двумя CPU и 16 модулями памяти хватает пары 800-ваттных PSU с резервированием. Под полную загрузку с 20 NVMe-накопителями и тремя ускорителями стоит закладывать 1400–1800 Вт.

Dell предлагает функцию Multi-Vector Cooling — динамическое управление вентиляторами на основе телеметрии с каждого компонента. Система не просто реагирует на перегрев, а предиктивно регулирует обороты в зависимости от профиля нагрузки. Звучит как маркетинг, но на деле это снижает акустический шум и потребление в периоды низкой активности.

Разговор о perf/W неизбежно приводит к сравнению с AMD EPYC — подробнее об этом мы писали в статье сравнение Intel и AMD для бизнеса. Xeon 6 E-core конкурирует с EPYC Bergamo/Turin в задачах throughput, а P-core — с EPYC Genoa/Turin в вычислительно-интенсивных сценариях. По SPEC-бенчмаркам Intel отыгрывает позиции, потерянные в эпоху Sapphire Rapids, хотя AMD сохраняет преимущество в ряде рабочих нагрузок — особенно в тестах, чувствительных к пропускной способности памяти (у EPYC 12 каналов против 8 у Xeon 6).

Выбор между платформами зависит от конкретного профиля нагрузки. Универсального ответа нет, и если кто-то вам его даёт — он, скорее всего, что-то продаёт.

Сценарии: где R670 раскрывается

Виртуализация (VMware, Proxmox, Hyper-V). До 172 P-ядер (2 сокета), 8 ТБ оперативки, петабайт локального NVMe-хранения. Для VDI и серверной виртуализации — одна из лучших платформ в 1U-сегменте, а определиться с платформой поможет наш разбор популярных гипервизоров. Поддержка vSphere 8 подтверждена. Если считать по стоимости за VM — R670 выигрывает у 2U-серверов за счёт экономии на стойко-местах.

Программно-определяемые хранилища (Ceph, vSAN). 20 NVMe-накопителей в одном узле — это плотность, которая сокращает количество нод в кластере. Меньше нод — проще управление, ниже латентность, меньше сетевого трафика между узлами. Для vSAN-кластера из четырёх R670 с конфигурацией 20x E3.S каждый получаем свыше 4 ПБ raw-ёмкости в 4U стоечного пространства.

ИИ-инференс и аналитика. Три ускорителя по 75 Вт для локального инференса, либо CPU-only вариант на E-core для лёгких моделей. Xeon 6 поддерживает AMX (Advanced Matrix Extensions), что ускоряет операции с матрицами без дополнительного оборудования. Для компаний, которые запускают RAG-пайплайны или real-time scoring, — рабочий вариант без покупки дорогостоящих GPU-серверов. Если ИИ — ваш основной сценарий, рекомендуем изучить, как выбрать и собрать сервер для ИИ под конкретные задачи.

Облачная инфраструктура и контейнеры. E-core с 144 ядрами на сокет — 288 ядер на сервер. Для Kubernetes-кластеров, где нужна плотность подов, а не скорость одного потока, это близко к идеалу. Каждое ядро — потенциальный pod с гарантированным CPU, и 288 ядер дают запас, которого хватит даже при агрессивном overcommit.

Стоит ли обновляться с R660

Если Ваш парк серверов на R660 справляется с текущей нагрузкой и горизонт планирования — год-два, острой необходимости в миграции нет. R660 — зрелая платформа, и Dell продолжает её поддерживать.

Но если вы закупаете новое оборудование или планируете масштабирование, R670 предлагает принципиально другой уровень: удвоение плотности ядер, переход на EDSFF с прицелом на PCIe Gen6, переработанная система управления. Переход с U.2 на E3.S — инвестиция в совместимость с будущими поколениями накопителей. Платить за это придётся сейчас, но альтернатива — замена бэкплейна через 2–3 года, когда PCIe Gen6 станет стандартом.

Отдельно стоит оценить изменения в управлении. Если Ваша команда тратит часы на ручное конфигурирование серверов через BIOS — iDRAC10 с Redfish API и Ansible-интеграцией окупится на первом же деплое. Время инженера стоит дороже, чем разница в цене между поколениями.

Dell PowerEdge R670 — не революция, а закономерное развитие платформы. Но то, как Dell упаковала петабайт NVMe и 288 ядер в один юнит, параллельно решив вопрос охлаждения и управляемости, — вызывает уважение чисто с инженерной точки зрения. Рекомендуем запросить тестовый экземпляр и прогнать Ваши рабочие нагрузки — цифры из бенчмарков хороши, но Ваш продакшн всегда умнее любого синтетического теста.