Из чего состоит СХД: контроллеры, полки и внутренняя архитектура

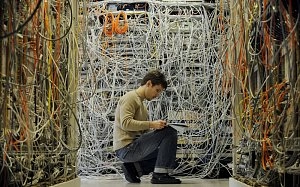

Вы когда-нибудь задумывались, как устроена система хранения данных за 1-2 миллиона рублей? Открываем серверный шкаф, смотрим на мигающий железный ящик - и что дальше? Давайте разберем СХД на запчасти и посмотрим, что там жужжит и почему оно стоит таких денег.

Система хранения данных - это не просто склад для файлов. Это высокотехнологичный комплекс из контроллеров, дисковых полок, кабелей и умного софта, который следит за тем, чтобы ваши данные были доступны 24/7, даже если половина железа откажет. Разберемся по порядку.

Контроллеры - мозг всей системы

Контроллер в СХД - это специализированный компьютер, который управляет потоками данных, распределяет нагрузку и следит за отказоустойчивостью. Если представить схд как здание, то контроллер - это лифтовая система, которая развозит данные по этажам (дискам) и следит, чтобы никто не застрял.

В профессиональных системах обычно два контроллера, которые работают в режиме Active-Active. Что это значит? Оба контроллера одновременно обрабатывают запросы, синхронизируя данные между собой по высокоскоростной линии связи. Упал один - второй мгновенно подхватывает всю нагрузку. Пользователи даже не заметят перерыва.

Есть и более простая схема Active-Passive, где второй контроллер спит до момента отказа первого. Дешевле, но переключение занимает несколько секунд - для критичных систем это недопустимо.

Внутри контроллера - процессор (часто многоядерный), оперативная память и кэш. Кэш заслуживает особого внимания. Это быстрая память, куда контроллер временно складывает часто запрашиваемые данные, чтобы не тормозить систему походами на медленные диски. Если кэш построен на флеш-накопителях, он ускоряет доступ к данным в 10 раз по сравнению с обычными жесткими дисками. Многоуровневое кэширование (RAM + Flash) стало стандартом для серьезных нагрузок.

Контроллеры также отвечают за управление трафиком. Представьте: 50 виртуальных машин одновременно просят данные. Контроллер решает, кому отдать приоритет, как распределить нагрузку между дисками, когда включить кэш. Это балансировка в реальном времени, и делается она на аппаратном уровне, разгружая ваши серверы.

Еще один плюс двухконтроллерной архитектуры - обновление прошивки без остановки системы. Обновили один контроллер, переключили трафик на второй, обновили его - готово. Простоя нет, данные доступны.

Дисковые полки - где живут данные

Если контроллеры - это мозг, то дисковые полки (или шелфы, от англ. shelf) - это склад. Полка представляет собой отдельный корпус, куда устанавливаются накопители. Обычно это 12, 24 или больше дисковых слотов в одном юните высотой 2-4U.

Полки бывают двух типов: JBOD (Just a Bunch of Disks) и RAID-шелфы. JBOD - это просто набор дисков без встроенной логики. Всей работой управляет контроллер СХД. RAID-шелфы умнее - у них есть собственный контроллер, который уже на уровне полки организует массивы, снижая нагрузку на основной контроллер.

Что касается дисков, в полки устанавливают три типа накопителей:

| Тип накопителя | Скорость (IOPS) | Объем | Применение |

|---|---|---|---|

| HDD (7200/10000 RPM) | 100-200 | До 20 ТБ | Архивы, холодные данные |

| SSD (SATA/SAS) | 10 000-100 000 | До 8 ТБ | Базы данных, виртуализация |

| NVMe SSD | 200 000-1 000 000 | До 16 ТБ | Высоконагруженные приложения, big data |

Гибридные конфигурации - когда в одной полке микшируются HDD и SSD - сейчас норма. Часто используемые данные автоматически переезжают на быстрые диски (это называется тиеринг), архивные остаются на медленных. Экономия и скорость одновременно.

Полки подключаются к контроллерам специальными кабелями - SAS или Fibre Channel. Расстояние зависит от протокола: SAS работает до 10 метров, FC - до сотен метров с оптикой. Можно выстроить цепочку полок, масштабируя систему до петабайт. Добавили новую полку - контроллер ее обнаружил, сбалансировал нагрузку, и всё работает дальше без перезагрузки.

Внутренняя архитектура и протоколы

Теперь про то, как всё это общается между собой и с внешним миром. СХД не существует в вакууме - она подключена к серверам, которым отдает данные. Для этого используются разные протоколы, и выбор зависит от задач.

iSCSI - передача блочных данных по обычной Ethernet-сети. Дешево, просто настраивается, но скорость ограничена пропускной способностью сети. Подходит для малого и среднего бизнеса, где нет требований к сверхвысокой производительности.

Fibre Channel (FC) - выделенная сеть хранения данных с пропускной способностью 8, 16 или 32 Гбит/с. Дороже в развертывании, зато минимальные задержки и стабильность. Банки, медицина, крупные дата-центры выбирают FC.

NVMe over Fabrics (NVMe-oF) - протокол будущего, который выжимает максимум из NVMe-дисков, снижая latency до микросекунд. Пока дорого, но для виртуализированных сред и аналитики больших данных это становится стандартом.

| Протокол | Скорость | Задержка | Применение |

|---|---|---|---|

| iSCSI | До 10 Гбит/с | Средняя | Малый/средний бизнес |

| FC | До 32 Гбит/с | Низкая | Критичные системы |

| NVMe-oF | До 100 Гбит/с | Минимальная | Big data, AI, HPC |

Внутри СХД данные организуются в RAID-массивы. RAID - это избыточное распределение информации по дискам для защиты от отказов. Уровни RAID разные: RAID 5 жертвует одним диском под четность, RAID 6 - двумя, RAID 10 зеркалирует диски попарно. Аппаратный RAID, который делает контроллер СХД, быстрее программного, потому что вычисления идут на специализированном железе.

Репликация данных - еще один уровень защиты. Контроллеры могут синхронно или асинхронно копировать данные на вторую СХД в другом здании или городе. Сгорел дата-центр - переключились на резервный, работаем дальше. Синхронная репликация дороже и медленнее (данные пишутся одновременно в оба хранилища), зато гарантирует нулевую потерю информации.

Производительность и масштабирование

Когда выбираете СХД, важно понимать, сколько операций ввода-вывода в секунду (IOPS) и какую пропускную способность (throughput) вы получите. Для баз данных критичны IOPS - много мелких операций чтения-записи. Для видеомонтажа или резервного копирования важнее throughput - скорость передачи больших файлов.

Расчет производительности зависит от рабочей нагрузки (workload). База данных с тысячами транзакций? Нужны NVMe-диски и минимум 50 000 IOPS. Файловый сервер с документами? Хватит SSD и 5000 IOPS. Архив? Пойдут HDD.

Балансировка нагрузки работает автоматически. Контроллер отслеживает "горячие точки" (hot spots) - диски или разделы, которые перегружены, и перераспределяет данные. Это называется автоматическим тиерингом или load balancing. Вы не заметите, что происходит под капотом, но система будет работать ровнее.

Масштабирование полок - отдельная тема. Начали с одной полки на 24 диска, потом добавили вторую, третью. Контроллер видит новые диски, включает их в массив, распределяет данные. Горячее масштабирование - фишка профессиональных СХД, позволяющая расти вместе с бизнесом.

Безопасность и мониторинг

Резервирование - основа отказоустойчивости СХД. Дублированы не только контроллеры, но и блоки питания, вентиляторы, кабели. Упал один блок питания - второй держит систему. Отключили электричество в здании - СХД переходит на батареи, сбрасывает данные из кэша на диски и корректно завершает работу.

Шифрование данных - стандарт для чувствительной информации. Диски с самошифрованием (SED, Self-Encrypting Drive) автоматически шифруют информацию на лету, не нагружая контроллер. Украли диск из полки - прочитать данные невозможно без ключа.

Мониторинг работает в реальном времени. Контроллер отслеживает температуру дисков, скорость деградации ячеек SSD, количество ошибок чтения. Predictive maintenance - прогнозирование отказов - позволяет заменить диск до того, как он умрет. Система видит, что диск начал сыпаться, шлет уведомление, вы заказываете замену. Данные уже перенесены на здоровые диски, простоя нет.

Инструменты для анализа hot spots помогают понять, где узкие места. Один LUN (логический диск) перегружен запросами? Перенесите его на более быстрые диски или распределите нагрузку. Это не гадание на кофейной гуще, а реальная телеметрия с графиками и метриками.

Куда движется индустрия

Гиперконвергентные системы размывают границы между вычислениями и хранением. В одном корпусе - и серверы, и СХД, управляемые единым софтом. Удобно для облачных провайдеров и виртуализированных сред, но классические СХД никуда не денутся - там, где нужна максимальная надежность и производительность, они остаются королями.

Объектное хранилище (object storage) набирает популярность для неструктурированных данных - фото, видео, логи. Объектные СХД масштабируются до сотен петабайт, но работают медленнее блочных. Разные задачи - разные инструменты.

Переход на NVMe идет полным ходом. Latency снижается с миллисекунд до десятков микросекунд, что критично для финансовых транзакций, анализа больших данных и искусственного интеллекта. Инфраструктура дорогая, но скорость окупает вложения.

Все компоненты СХД работают как оркестр - контроллеры дирижируют, полки держат ноты, протоколы передают музыку. Понимание архитектуры помогает не только выбрать правильное железо, но и грамотно его эксплуатировать. Система хранения данных - это не черный ящик, а продуманная инженерная конструкция, где каждая деталь выполняет свою роль.