Нужна ли видеокарта для сервера: разбираем задачи и сценарии

Вопрос, который слышишь постоянно: нужна ли серверу видеокарта? Короткий ответ — в большинстве случаев нет. Серверы отлично работают без GPU, выполняя привычные задачи: обрабатывают запросы, хранят данные, управляют базами. Процессор справляется сам. Но есть ситуации, когда без серверной видеокарты проект просто встанет. И вот здесь начинается самое интересное.

Представьте: ваш CPU обрабатывает задачу машинного обучения трое суток. А GPU делает то же самое за несколько часов. Разница колоссальная. Почему так происходит? Всё дело в архитектуре. Процессор — это мастер на все руки с несколькими сильными руками (ядрами), каждая из которых последовательно выполняет сложные операции. Видеокарта — это толпа из тысяч помощников, где каждый делает простую операцию, но все работают одновременно. Когда задача требует обработать миллионы однотипных вычислений параллельно, GPU побеждает с огромным отрывом.

Когда GPU становится не прихотью, а необходимостью

Машинное обучение и искусственный интеллект — главные потребители серверных GPU сегодня. Обучение нейронной сети — это миллиарды матричных операций, которые нужно провести снова и снова. CPU будет делать это медленно, последовательно перебирая каждую операцию. Серверная GPU с тысячами ядер CUDA запускает эти операции пачками, параллельно. Разница в скорости может достигать 50-100 раз. Если вы работаете с TensorFlow, PyTorch или другими фреймворками глубокого обучения, без видеокарты работа превратится в пытку.

Научные вычисления — ещё одна сфера, где видеокарты незаменимы. Моделирование молекулярной динамики, расчет климатических моделей, анализ генетических данных — всё это требует обработки огромных массивов информации. Университеты и исследовательские центры давно поняли: инвестиция в серверы с GPU окупается сокращением времени расчетов в десятки раз.

3D-рендеринг и обработка видео тоже сильно зависят от GPU. Студия, которая создает визуальные эффекты или рекламные ролики, не может ждать неделю, пока CPU отрендерит сцену. С профессиональной видеокартой процесс ускоряется кратно. То же касается транскодинга видео в разные форматы, обработки потокового контента, создания превью.

Виртуализация с графической нагрузкой — менее очевидный, но важный сценарий. Если вы предоставляете виртуальные рабочие столы (VDI) или облачные рабочие станции для дизайнеров, инженеров, разработчиков игр, им нужна графика. Без GPU виртуальные машины будут тормозить на любых графических задачах. Технологии вроде NVIDIA vGPU позволяют делить одну физическую видеокарту между несколькими виртуальными машинами, давая каждой нужную производительность.

Профессиональные против десктопных: в чём разница

Вы можете спросить: зачем покупать дорогую серверную видеокарту, если можно взять мощную игровую за меньшие деньги? Вопрос резонный. Десктопные GPU (GeForce RTX, Radeon RX) стоят дешевле и предлагают впечатляющую производительность. Но есть нюансы, которые делают их не лучшим выбором для серверов.

Профессиональные карты (NVIDIA Tesla, A100, H100, AMD Instinct) созданы специально для круглосуточной работы под нагрузкой. Они имеют:

- Больше видеопамяти. Серверные GPU могут иметь 40, 80 и больше гигабайт VRAM. Это критично для обучения больших моделей, где нужно загрузить гигантские датасеты.

- Коррекцию ошибок (ECC). Память с ECC обнаруживает и исправляет ошибки, что важно для научных расчетов, где точность данных критична.

- Оптимизацию под вычисления двойной точности (FP64). Игровые карты заточены под вычисления одинарной точности, а научные задачи часто требуют FP64.

- Лучшее охлаждение и надежность. Серверные карты рассчитаны на работу 24/7 в условиях дата-центров с высокой температурой и плотной компоновкой.

Вот сравнительная таблица:

| Характеристика | Серверная GPU (NVIDIA A100) | Десктопная GPU (RTX 4090) |

|---|---|---|

| Видеопамять | 40-80 ГБ HBM2e | 24 ГБ GDDR6X |

| ECC память | Есть | Нет |

| FP64 производительность | Высокая | Урезанная |

| Срок службы | 5+ лет непрерывной работы | 2-3 года |

| Цена | От 10 000 $ | От 1 600 $ |

| Драйверы для AI | Оптимизированы (CUDA, cuDNN) | Поддерживаются, но хуже |

Десктопные карты могут быть разумным компромиссом для небольших проектов, стартапов или обучения моделей средней сложности. Но если речь о продакшене, критичных вычислениях или масштабируемости, профессиональные решения окупаются стабильностью и производительностью.

Что важно при выборе видеокарты для сервера

Итак, вы решили, что GPU нужна. Как выбрать? Вот ключевые параметры, на которые стоит смотреть:

Объем видеопамяти (VRAM). Чем больше, тем лучше для машинного обучения и обработки данных. Если модели большие, берите от 32 ГБ и выше. Для рендеринга или транскодинга можно обойтись 16-24 ГБ.

Количество ядер и их тип. Ядра CUDA (NVIDIA) или Stream Processors (AMD) — чем их больше, тем выше параллельная производительность. Для AI-задач важны тензорные ядра, которые ускоряют операции с матрицами в сотни раз.

Совместимость с софтом. Убедитесь, что ваша карта поддерживается фреймворками, которые вы используете. NVIDIA доминирует в AI благодаря CUDA, но AMD Instinct тоже поддерживает ROCm и набирает популярность.

Энергопотребление и охлаждение. Мощные GPU потребляют 300-700 Вт. Проверьте, потянет ли ваш блок питания и система охлаждения. В дата-центрах это особенно важно — перегрев приведет к троттлингу и снижению производительности.

Бюджет. Топовые карты стоят как автомобиль. Оцените реально: может, вам хватит модели средней руки? Или можно арендовать облачные вычисления (AWS, Google Cloud) вместо покупки железа?

Когда можно обойтись без видеокарты

Давайте честно: в большинстве бизнес-сценариев серверу GPU не нужна. Веб-серверы, базы данных, почтовые системы, файловые хранилища, ERP и CRM прекрасно работают на процессорах. Даже виртуализация без графических задач обходится без видеокарт.

Если ваш сервер обрабатывает транзакции, хранит документы или управляет сетевым трафиком — GPU будет простаивать. Инвестируйте лучше в процессор с большим количеством ядер, оперативную память и быстрые SSD. Это даст куда больший прирост производительности для стандартных задач.

GPU стоит рассматривать, только если у вас есть специфическая нагрузка: обучение моделей, сложные расчеты, рендеринг или обработка видео. В остальных случаях это лишняя трата денег и энергии.

Особенности сборки сервера с видеокартами

Установка GPU в сервер — это не просто воткнуть карту в слот PCIe. Нужно учесть несколько моментов:

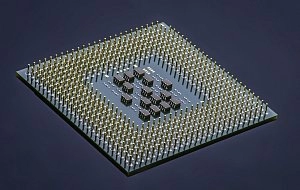

Форм-фактор. Серверные корпуса бывают разные. Убедитесь, что карта физически поместится. Некоторые GPU занимают 2-3 слота по ширине и требуют много места.

Питание. Проверьте, есть ли у блока питания нужные разъемы (PCIe 8-pin, 12-pin) и хватит ли мощности на всю систему. Для конфигураций с несколькими GPU может понадобиться БП на 1500-2000 Вт.

Охлаждение. Мощные видеокарты греются. В серверах часто используют пассивное охлаждение (без вентиляторов на самой карте), полагаясь на мощный поток воздуха в корпусе. Убедитесь, что система вентиляции справится.

Драйверы и софт. После установки нужно настроить драйверы, библиотеки (CUDA, cuDNN для NVIDIA), проверить совместимость с операционной системой и фреймворками.

Настройка может занять время, особенно если у вас несколько карт и вы планируете распределять нагрузку между ними.

Стоит ли инвестировать в GPU: взгляд практика

Если вы IT-руководитель или системный администратор, вот простой чек-лист для принятия решения:

- У вас есть задачи, требующие параллельных вычислений? (ML, AI, рендеринг, научные расчеты)

- Текущие сроки выполнения задач на CPU неприемлемо долгие?

- Есть бюджет на покупку и обслуживание GPU-сервера?

- Инфраструктура поддерживает энергопотребление и охлаждение?

Если ответы "да" — вперед, GPU окупится сокращением времени разработки и ускорением проектов. Если хотя бы на один вопрос ответили "нет" — подумайте о компромиссах: аренда облачных GPU, покупка десктопных карт для тестов или просто оптимизация существующего кода.

GPU — мощный инструмент, но только в правильных руках и для правильных задач. Не стоит гнаться за модой на нейросети, если ваш бизнес в них не нуждается. Зато если нуждается — откладывать покупку тоже смысла нет. Время — деньги, а GPU экономит время как никто другой.