Технологии динамического управления питанием серверов (DPPM)

- Что такое DPPM и почему это важно именно сейчас

- Как это работает: от теории к железу

- Виртуализация: главный enabler технологии

- Железная сторона вопроса: что умеют современные процессоры

- Практическая настройка: где собака зарыта

- Реальные цифры: сколько можно сэкономить

- Программные решения: кто что предлагает

- Подводные камни и как их обойти

- Взгляд в будущее: AI и машинное обучение

Представьте: типичный корпоративный сервер загружен в среднем на 20-30% от максимальной мощности. При этом потребляет он 60-90% от пикового энергопотребления. Это как если бы ваш автомобиль на холостом ходу сжигал почти столько же бензина, сколько на скорости 100 км/ч. Абсурд? Для серверов это была норма до появления технологий динамического управления питанием.

Что такое DPPM и почему это важно именно сейчас

Dynamic Power and Performance Management (DPPM) — технология, которая делает серверы умнее в плане энергопотребления. Если совсем просто: система постоянно мониторит нагрузку и автоматически регулирует мощность компонентов. Нужна производительность — получите. Нагрузка упала — потребление снижается.

Казалось бы, очевидное решение. Но дьявол, как всегда, в деталях. Серверы — это не ноутбуки. Здесь критически важна стабильность, предсказуемость времени отклика, готовность к мгновенным всплескам нагрузки. Один неправильно настроенный параметр — и вместо экономии получите тормозящие приложения и недовольных пользователей.

Почему об этом заговорили именно сейчас? Три фактора сошлись в одной точке:

- Стоимость электроэнергии — за последние годы тарифы выросли в разы, и это уже не мелкая строчка в бюджете, а существенная статья расходов

- Экологические требования — углеродный след IT-инфраструктуры стал предметом отчетности и регулирования

- Технологическая зрелость — процессоры и системы управления наконец-то научились переключаться между режимами без потери производительности

Как это работает: от теории к железу

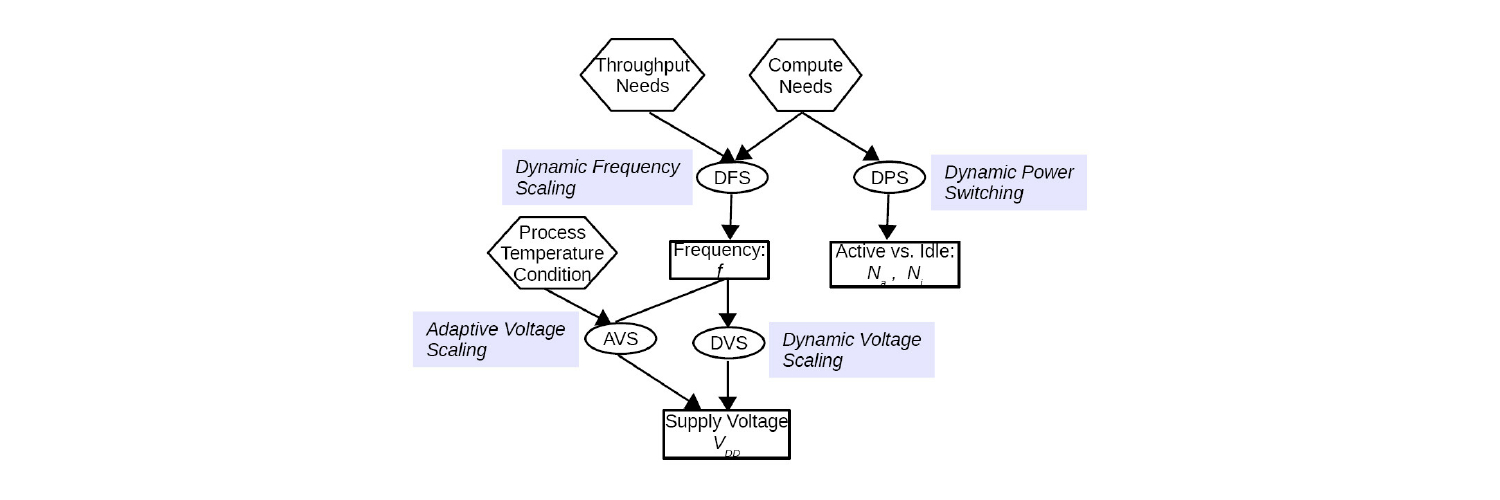

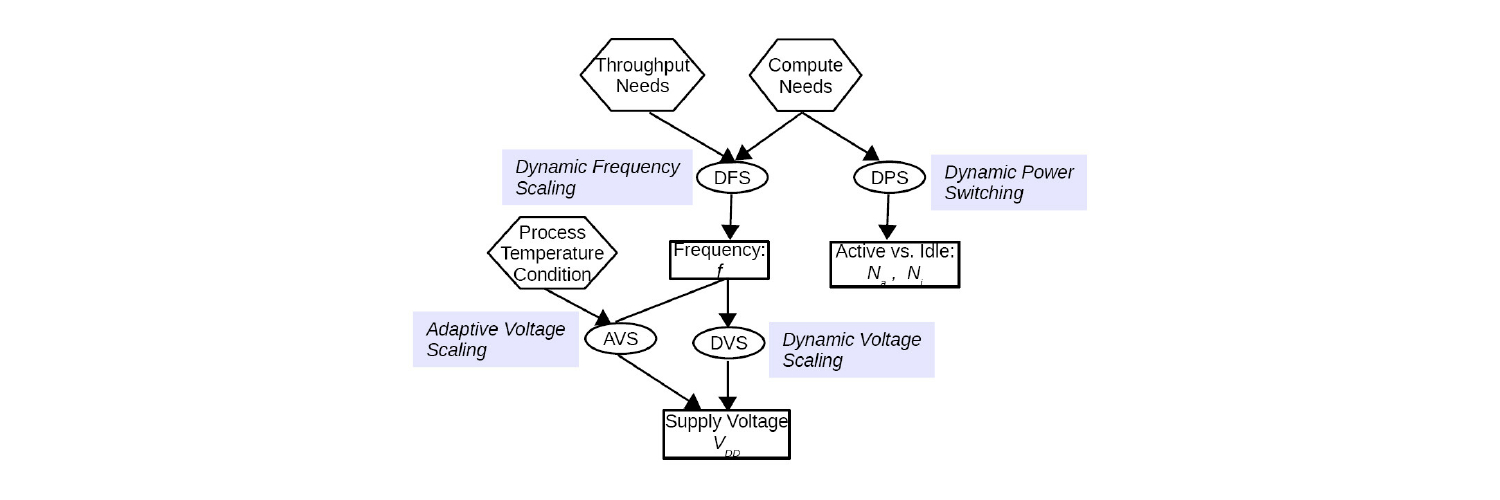

Современные процессоры поддерживают несколько энергосберегающих состояний. Это не просто "включено/выключено", а целый спектр режимов работы.

|

Тип состояния |

Что происходит |

Время переключения |

Экономия энергии |

|

P-States (Performance) |

Изменение частоты и напряжения процессора |

Микросекунды |

10-40% |

|

C-States (Core) |

Отключение неиспользуемых ядер и блоков |

Миллисекунды |

30-70% |

|

T-States (Throttle) |

Пропуск тактов процессора |

Наносекунды |

5-15% |

|

S-States (System) |

Переход всей системы в режим сна |

Секунды |

До 95% |

Но железо — это только половина истории. DPPM серверы работают в связке с системами виртуализации и оркестрации. Вот где начинается настоящая магия.

Представим типичный сценарий: ночь, нагрузка на корпоративные приложения минимальная. Система DPPM начинает консолидацию — виртуальные машины с малоактивных хостов мигрируют на несколько активных серверов. Освободившиеся узлы переводятся в режим глубокого сна или вообще выключаются. Утром, за час до начала рабочего дня, система прогнозирует рост нагрузки и заранее будит нужное количество серверов. Пользователи приходят на работу — инфраструктура уже готова.

Звучит просто? На деле это сложнейшая оркестрация десятков параметров. Система должна учитывать:

- Текущую загрузку CPU, памяти, дисковой подсистемы, сети

- Исторические паттерны нагрузки

- Критичность запущенных приложений

- Время, необходимое для миграции VM

- Тепловую карту дата-центра

- Договорные обязательства по SLA

Виртуализация: главный enabler технологии

Без виртуализации динамическое управление питанием было бы почти невозможно. Именно способность перемещать рабочие нагрузки между физическими серверами делает DPPM по-настоящему эффективным.

Рассмотрим, как это работает на практике. У вас есть кластер из 10 серверов, на которых крутится 100 виртуальных машин. В пиковые часы все 10 серверов работают на 70-80% мощности. Ночью нагрузка падает до 20%. Без DPPM все 10 серверов продолжат потреблять 60-70% от максимальной мощности. С DPPM система соберет все VM на 3-4 сервера, загрузив их на те же 70-80%, а остальные 6-7 серверов уйдут в глубокий сон, потребляя 5-10% энергии.

Математика простая: вместо 10 серверов × 70% потребления = 700 условных единиц энергии, получаем 3 сервера × 90% + 7 серверов × 10% = 340 условных единиц. Экономия больше 50%!

Но есть нюансы. Миграция VM — это не бесплатная операция. Она создает нагрузку на сеть и системы хранения, может вызвать кратковременные задержки. Поэтому алгоритмы DPPM должны быть умными: не дергать VM туда-сюда при каждом колебании нагрузки, учитывать "стоимость" миграции, прогнозировать будущую нагрузку.

Железная сторона вопроса: что умеют современные процессоры

Intel и AMD за последние годы серьезно прокачали энергосберегающие функции своих процессоров. И это уже не маркетинговые фишки, а реально работающие технологии.

Intel SpeedShift позволяет процессору менять частоту за микросекунды, причем решение принимается на уровне железа, без участия ОС. Это критически важно для серверных нагрузок, где задержка в миллисекунду может быть неприемлемой.

AMD Cool'n'Quiet и более новая AMD PowerNow! делают похожие вещи, но с другим подходом к управлению напряжением. AMD традиционно сильна в многоядерных конфигурациях, и их технологии позволяют очень гранулярно управлять отдельными CCX (Core Complex).

Современные серверные платформы идут еще дальше. Они умеют:

- Отключать отдельные банки памяти

- Переводить PCIe-слоты в энергосберегающие режимы

- Управлять скоростью вентиляторов с точностью до оборотов

- Динамически перераспределять мощность между компонентами

Всё это управляется через BMC (Baseboard Management Controller) и может быть настроено под конкретные задачи. Хотите максимальную производительность? Пожалуйста. Нужна максимальная экономия? Тоже можно. А можно найти золотую середину для каждого конкретного приложения.

Практическая настройка: где собака зарыта

Теперь о том, о чем вендоры обычно умалчивают. Настройка DPPM — это не просто передвинуть ползунок "Экономия ← → Производительность". Это десятки параметров в BIOS, настройки гипервизора, политики операционной системы, конфигурация приложений.

|

Уровень настройки |

Основные параметры |

Влияние на систему |

|

BIOS/UEFI |

C-States, P-States, Turbo Boost, Power Capping |

Базовое поведение железа |

|

Гипервизор |

DPM, DRS, политики миграции |

Распределение нагрузки |

|

ОС |

Power Governor, CPU Frequency Scaling |

Реакция на изменение нагрузки |

|

Приложения |

Thread Affinity, Priority Classes |

Требования к ресурсам |

Типичные грабли, на которые наступают при внедрении:

Слишком агрессивные настройки энергосбережения. Сервер начинает "тупить" при резком росте нагрузки. Пользователи жалуются на лаги, администраторы в панике откатывают все настройки.

Игнорирование специфики приложений. База данных и веб-сервер требуют разных подходов к управлению питанием. То, что хорошо для одного, может убить производительность другого.

Неучтенные зависимости. Выключили сервер с второстепенным приложением, а оказалось, что к нему обращается критичный сервис. Результат предсказуем.

Реальные цифры: сколько можно сэкономить

Давайте посчитаем на примере небольшого дата-центра с 50 серверами. Средняя мощность сервера — 500 Вт, работают 24/7, тариф — 5 рублей за кВт·ч.

Без DPPM:

- 50 серверов × 500 Вт × 24 часа × 365 дней = 219 000 кВт·ч в год

- 219 000 × 5 рублей = 1 095 000 рублей в год

С DPPM (консервативная оценка экономии 30%):

- 219 000 × 0.7 = 153 300 кВт·ч в год

- 153 300 × 5 = 766 500 рублей в год

- Экономия: 328 500 рублей в год

И это только прямая экономия на электричестве. Добавьте сюда снижение нагрузки на системы охлаждения (еще минус 10-15%), увеличение срока службы оборудования, уменьшение требований к мощности ИБП.

Программные решения: кто что предлагает

Рынок решений для динамического управления питанием довольно разнообразен. Каждый вендор тянет одеяло на себя, но есть и универсальные решения.

VMware vSphere с функцией Distributed Power Management (DPM) — пожалуй, самое зрелое решение. Работает из коробки, интегрировано с DRS (Distributed Resource Scheduler), умеет прогнозировать нагрузку. Минус — привязка к экосистеме VMware.

Microsoft Windows Server с ролью Hyper-V тоже умеет в динамическое управление питанием, но настройка требует больше ручной работы. Зато интеграция с Active Directory и групповыми политиками позволяет очень гибко управлять режимами работы.

Linux с KVM и различными системами оркестрации (OpenStack, Kubernetes) дает максимальную гибкость, но требует глубокого понимания всех компонентов стека. Зато можно настроить буквально всё, вплоть до custom-скриптов для управления питанием.

H3C CAS и другие решения китайских вендоров набирают популярность благодаря агрессивному ценообразованию и неплохой функциональности. Правда, документация часто хромает, и community-поддержка пока слабовата.

Подводные камни и как их обойти

За годы внедрения DPPM накопилось достаточно опыта, чтобы выделить типичные проблемы и способы их решения.

Проблема латентности. Выход из глубокого сна занимает время. Для некоторых приложений даже секундная задержка критична.

Решение: используйте прогнозирующие алгоритмы, держите "горячий резерв" серверов в неглубоком сне, настройте приоритеты для критичных приложений.

Износ оборудования. Частые циклы включения-выключения теоретически могут сократить срок службы компонентов.

Решение: настройте гистерезис — минимальное время между переключениями состояний. Современное оборудование рассчитано на десятки тысяч циклов, так что при разумной настройке проблем не будет.

Сложность отладки. Когда что-то идет не так, найти причину в динамически меняющейся системе бывает непросто.

Решение: логирование, логирование и еще раз логирование. Настройте подробный мониторинг всех параметров DPPM, используйте системы корреляции событий.

Взгляд в будущее: AI и машинное обучение

Следующий шаг в развитии DPPM — это использование искусственного интеллекта для управления энергопотреблением. И это не футуризм, а уже происходящая реальность.

Современные системы собирают терабайты данных о поведении инфраструктуры. Паттерны нагрузки, зависимости между приложениями, влияние внешних факторов (время суток, день недели, даже погода) — всё это можно скормить нейросети и получить предсказания с точностью до процентов.

Google в своих дата-центрах уже использует DeepMind для оптимизации охлаждения и управления питанием. Результат — дополнительные 15% экономии сверх традиционных методов. Microsoft экспериментирует с подводными дата-центрами Project Natick, где DPPM работает в связке с приливными циклами для максимальной эффективности.

Для обычных компаний такие технологии тоже становятся доступнее. Уже сейчас можно найти решения, которые используют машинное обучение для оптимизации DPPM в масштабах небольшого дата-центра. Цены пока кусаются, но тренд понятен — через несколько лет это станет стандартом.

Технологии динамического управления питанием — это не просто способ сэкономить на счетах за электричество. Это фундаментальное изменение подхода к проектированию и эксплуатации IT-инфраструктуры. Серверы перестают быть тупыми потребителями энергии и становятся умными устройствами, которые адаптируются под реальные потребности бизнеса.

Да, внедрение требует усилий. Да, придется разобраться в настройках и, возможно, наступить на пару граблей. Но альтернатива — продолжать платить за киловатты, которые греют воздух в серверной — выглядит всё менее привлекательной. Особенно когда конкуренты уже оптимизировали свои расходы и могут позволить себе более агрессивное ценообразование.

Вопрос не в том, нужно ли внедрять DPPM. Вопрос в том, когда вы начнете это делать. И чем раньше — тем больше сэкономите. Математика, знаете ли, штука упрямая.