GPU-серверы для задач машинного обучения и искусственного интеллекта

- Почему GPU, а не CPU?

- Анатомия GPU-сервера для ML/AI задач

- Графические процессоры — сердце системы

- Процессоры — дирижеры оркестра

- Память и хранилище — ключевые элементы производительности

- Охлаждение и энергопитание — незаменимые спутники мощности

- Архитектурные решения для GPU-серверов

- Высокоплотные решения

- Модульные решения

- Гибридные облачные решения

- Как выбрать GPU-сервер под конкретные задачи ML/AI

- Обучение больших моделей

- Инференс моделей в производстве

- Исследовательские задачи и разработка

- На что еще обратить внимание при выборе GPU-сервера

- Программное обеспечение и экосистема

- Масштабируемость и будущая модернизация

- Стоимость владения

Давайте разберемся, почему GPU-серверы стали стандартом в индустрии машинного обучения, какие решения существуют на рынке и как выбрать оптимальную конфигурацию под ваши задачи. Если нужен готовый GPU-сервер для машинного обучения — можно сразу перейти в каталог, а здесь мы разберём, на что смотреть при выборе.

Почему GPU, а не CPU?

Прежде чем говорить о серверах, давайте выясним, почему графические процессоры так хороши для задач искусственного интеллекта. Дело в архитектуре — CPU создан для последовательного выполнения разнообразных задач, а GPU — для параллельного выполнения множества однотипных операций.

Нейросети — это в первую очередь матричные вычисления. Много-много матричных вычислений. И вот тут GPU показывает себя во всей красе. Представьте, что вам нужно перемножить две матрицы размером 1000×1000. CPU будет делать это последовательно, а GPU — одновременно по всему фронту.

Вот наглядное сравнение производительности для типичных задач машинного обучения:

| Параметр | CPU (Intel Xeon) | GPU (NVIDIA A100) | Преимущество GPU |

|---|---|---|---|

| Производительность (FP32) | ~2 TFLOPS | ~19.5 TFLOPS | ~10x |

| Параллельные вычисления | Ограничены (десятки ядер) | Масштабируемы (тысячи ядер) | ~100x |

| Энергоэффективность | Средняя | Высокая | ~4x |

| Обучение ResNet-50 | ~24 часа | ~2 часа | ~12x |

Разница колоссальная. И это только один GPU против одного CPU. А теперь представьте сервер с восемью A100 — это уже космические скорости.

Анатомия GPU-сервера для ML/AI задач

GPU-сервер для машинного обучения — это не просто обычный сервер с добавленными видеокартами. Это тщательно сбалансированная система, где каждый компонент подобран для максимальной производительности всего комплекса.

Вот ключевые элементы, на которые стоит обратить внимание:

Графические процессоры — сердце системы

Графический процессор — это главная звезда шоу. На рынке доминируют решения NVIDIA серии RTX, Tesla (теперь серии A) и Quadro для профессиональных задач. AMD также предлагает интересные решения с линейкой Instinct, а Intel недавно выпустила свои GPU Arc для вычислений.

Для серьезных задач машинного обучения чаще всего используются:

- NVIDIA A100 — флагман для дата-центров и суперкомпьютеров

- NVIDIA H100 — новейшее решение с поддержкой Transformer Engine

- NVIDIA RTX 6000 — компромисс между стоимостью и производительностью

- AMD Instinct MI250 — альтернатива для сред, где предпочитают открытые стандарты

Процессоры — дирижеры оркестра

CPU в ML-сервере играет роль координатора, который распределяет задачи и обрабатывает части рабочего процесса, не подходящие для GPU. Мощный процессор важен для:

- Предобработки данных перед отправкой на GPU

- Оркестрации многих параллельных вычислений

- Управления системой и обеспечения стабильности под нагрузкой

Современные серверы часто комплектуются процессорами AMD EPYC или Intel Xeon последних поколений с большим количеством ядер и поддержкой высокоскоростной памяти. Подробнее о том, что выгоднее для бизнеса — Intel или AMD, мы разобрали в отдельном материале.

Память и хранилище — ключевые элементы производительности

Машинное обучение требует огромных объемов памяти. Для эффективной работы нужно:

- Оперативная память: минимум 2-4 ГБ на каждый ГБ памяти GPU. Для серверов с несколькими A100 (каждый с 40-80 ГБ VRAM) это означает 256-512 ГБ RAM. Разобраться в особенностях и типах серверной оперативной памяти поможет наш отдельный гайд.

- Быстрые SSD для хранения наборов данных и моделей: NVMe-накопители с высокой пропускной способностью (желательно с интерфейсом PCIe 4.0 или новее).

- Системы хранения для больших датасетов: быстрые сетевые хранилища или локальные RAID-массивы.

Задержка доступа к данным может стать узким местом всей системы, поэтому экономить на подсистеме хранения не стоит.

Охлаждение и энергопитание — незаменимые спутники мощности

Представьте, у вас стоят 4 GPU, каждый с TDP 300-400 Вт. Это 1200-1600 Вт только на видеокарты! А ведь есть еще процессоры, память, накопители... Общее энергопотребление легко переваливает за 2 кВт. Такое количество энергии превращается в тепло, которое нужно эффективно отводить.

Для серьезных GPU-серверов необходимы:

- Блоки питания с запасом мощности и высоким КПД (Titanium или Platinum)

- Продуманная система охлаждения, часто с жидкостным контуром для GPU

- Соответствующая инфраструктура серверной комнаты

Архитектурные решения для GPU-серверов

Когда дело доходит до конкретных конфигураций, существует множество подходов к построению GPU-серверов для ИИ. Если вы хотите разобраться в базовых принципах, рекомендуем статью о том, как выбрать и собрать сервер для ИИ под реальные задачи.

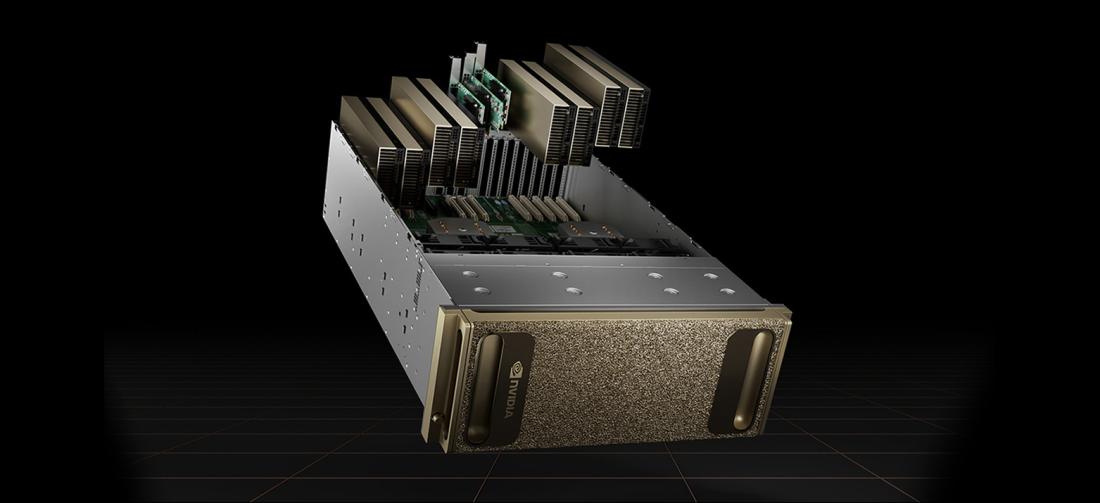

Высокоплотные решения

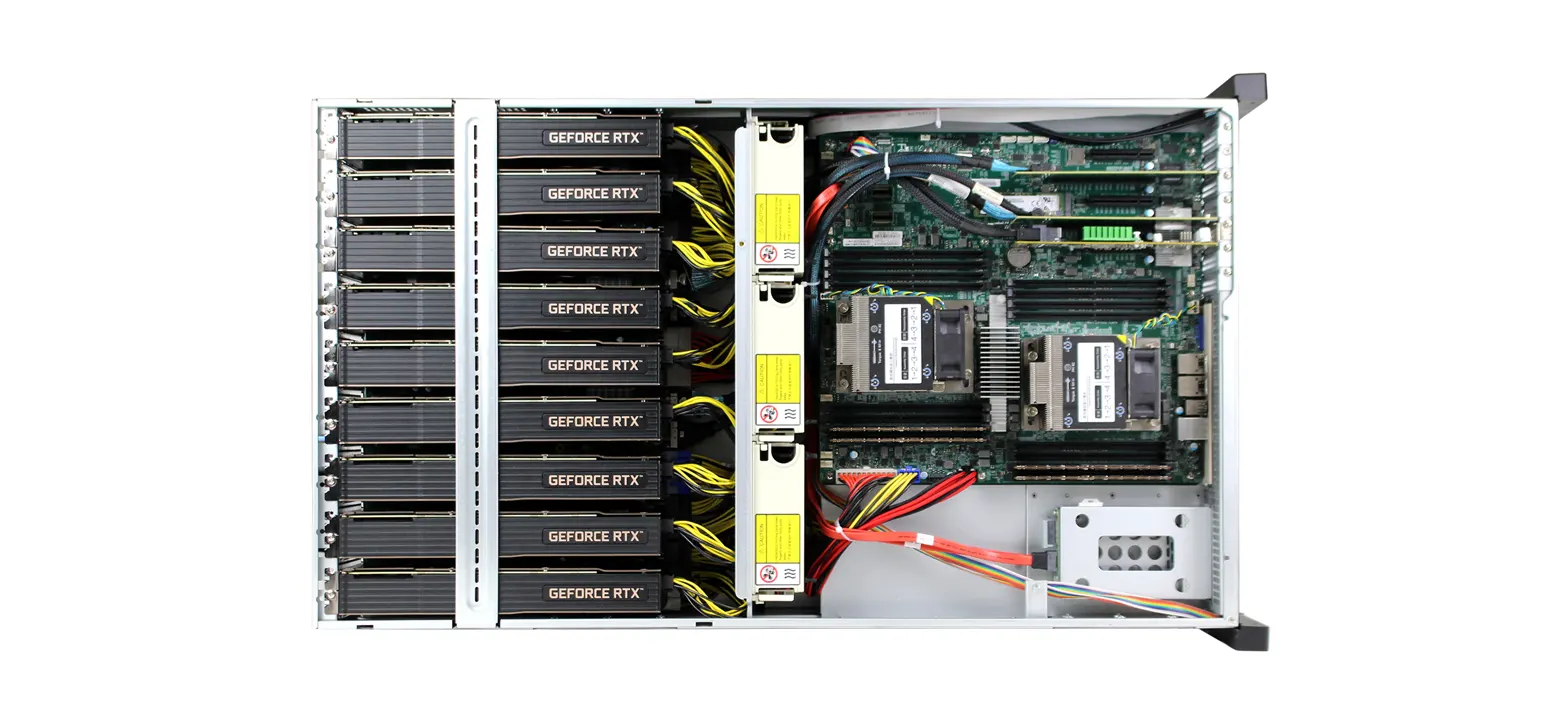

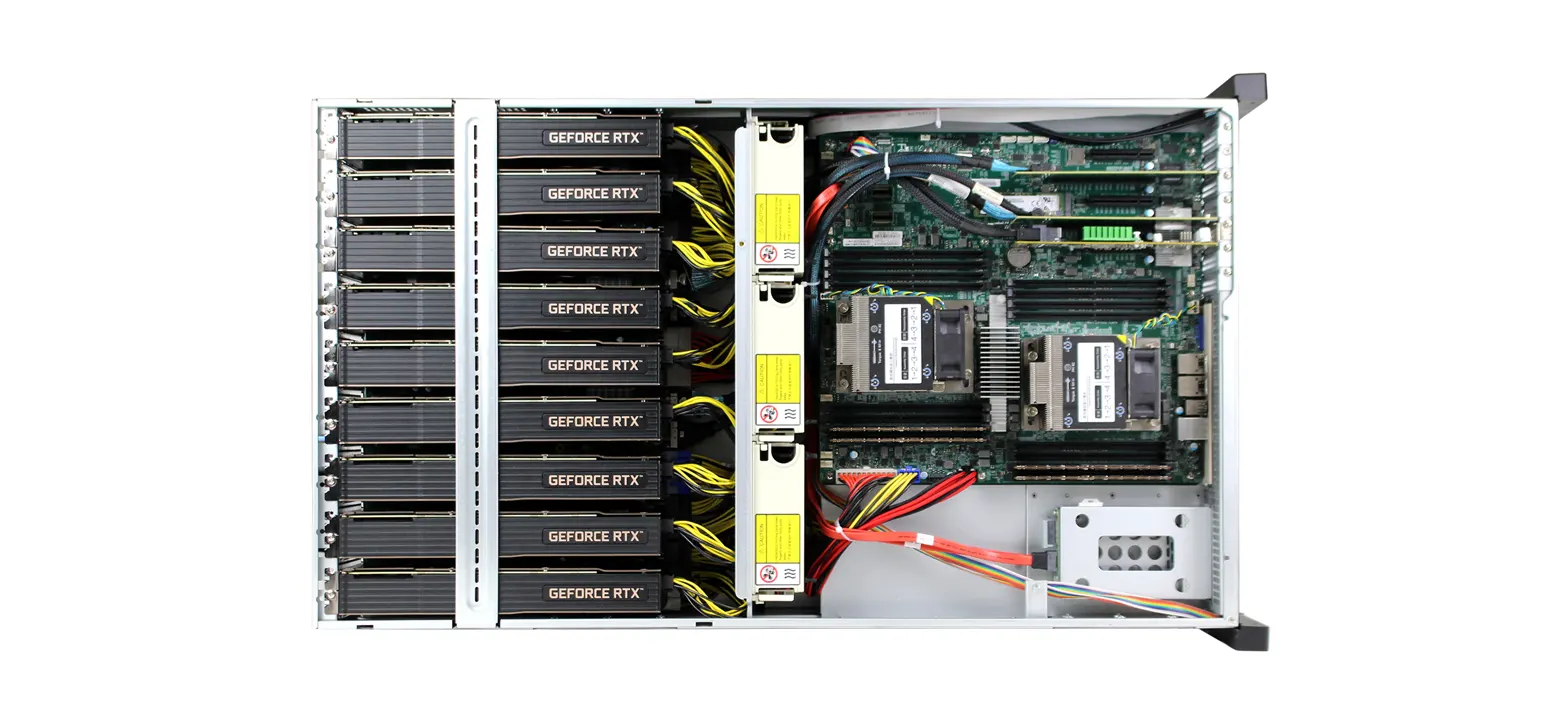

Высокоплотные GPU-серверы максимизируют количество графических процессоров в ограниченном пространства стойки. Типичные особенности:

- Специальный форм-фактор 4U или 8U для 8-16 GPU

- Общая система охлаждения для всех компонентов

- Оптимизированная внутренняя топология для минимизации задержек

- Встроенные высокоскоростные коммутаторы NVLink или InfiniBand

Эти монстры идеальны для обучения масштабных моделей, но требуют серьезных вложений и специальной инфраструктуры.

Модульные решения

Не всем нужна ракета для полета на дачу. Модульные системы позволяют начать с малого и расширяться по мере необходимости:

- Стандартные серверы 1U-2U с 2-4 GPU

- Возможность кластеризации через высокоскоростную сеть

- Гибкость в выборе компонентов

- Проще в обслуживании и модернизации

Это хороший баланс между производительностью и сложностью для команд среднего размера.

Гибридные облачные решения

Иногда разумнее комбинировать локальные вычисления с облачными:

- Базовые вычисления на собственных серверах

- Масштабирование в облако при пиковых нагрузках

- Специализированные задачи на оптимизированных облачных GPU-инстансах

Такой подход требует дополнительной работы над инфраструктурой, но может быть наиболее экономически эффективным в долгосрочной перспективе.

Как выбрать GPU-сервер под конкретные задачи ML/AI

Выбор конфигурации напрямую зависит от задач, которые вы планируете решать. Давайте рассмотрим типичные сценарии:

Обучение больших моделей

Если вы работаете над собственными языковыми моделями или глубокими нейросетями, то здесь критически важны:

- Максимальная вычислительная мощность

- Высокая пропускная способность между GPU (NVLink или аналоги)

- Огромные объемы памяти GPU (желательно с поддержкой Multi-Instance GPU)

- Мощная сетевая инфраструктура для распределенного обучения

Рекомендуемая конфигурация: 8×NVIDIA A100/H100 с NVLink, 512 ГБ RAM, быстрые NVMe SSD.

Инференс моделей в производстве

Для запуска уже обученных моделей требования иные:

- Стабильность и надежность

- Энергоэффективность

- Оптимизация под конкретные модели (иногда достаточно меньшей точности вычислений)

- Масштабируемость для обработки множества параллельных запросов

Рекомендуемая конфигурация: Серверы с NVIDIA T4/A10/A30, оптимизированные для низких задержек.

Исследовательские задачи и разработка

Для команд, занимающихся исследованиями и разработкой:

- Гибкость и универсальность конфигурации

- Хорошее соотношение цена/производительность

- Возможность быстрого переключения между задачами

- Удобство администрирования и мониторинга

Рекомендуемая конфигурация: 2-4×NVIDIA RTX A6000/A5000 или AMD аналоги, 256 ГБ RAM.

Вот сравнительная таблица для типичных задач:

| Задача | Рекомендуемые GPU | Минимальное количество | Особенности конфигурации |

|---|---|---|---|

| Обучение трансформеров(FP32) | NVIDIA A100/H100 | 4+ | Обязателен NVLink, высокоскоростная память |

| Компьютерное зрение | NVIDIA A10/RTX A6000 | 2-4 | Баланс между VRAM и производительностью |

| Рекомендательные системы | NVIDIA T4/A30 | 4-8 | Акцент на пропускную способность |

| Исследования и прототипирование | RTX A5000/A6000 | 1-2 | Гибкость конфигурации |

| Инференс в реальном времени | T4/A10 | 2+ на сервис | Оптимизация под низкую задержку |

На что еще обратить внимание при выборе GPU-сервера

Покупка сервера для машинного обучения — это долгосрочная инвестиция. Помимо технических характеристик, важны и другие аспекты:

Программное обеспечение и экосистема

Железо — это только часть уравнения. Для эффективной работы нужна развитая программная экосистема:

- CUDA для NVIDIA или ROCm для AMD

- Оптимизированные библиотеки (cuDNN, NCCL, TensorRT)

- Инструменты мониторинга и управления (NVIDIA DCGM, Ganglia)

- Поддержка контейнеризации и оркестрации (Docker, Kubernetes)

NVIDIA пока лидирует в этой области, предлагая более зрелую экосистему, но AMD активно наверстывает.

Масштабируемость и будущая модернизация

AI-модели растут в размерах с невероятной скоростью. Что было передовым вчера, становится базовым требованием сегодня. Поэтому:

- Выбирайте платформы с возможностью апгрейда

- Продумывайте стратегию масштабирования заранее

- Рассматривайте модульные решения для постепенного роста

- Учитывайте совместимость с будущими поколениями GPU

Стоимость владения

Начальная цена — это только верхушка айсберга. Общая стоимость владения включает:

- Затраты на электроэнергию (GPU-сервер может потреблять до 30 000 кВт·ч в год!)

- Охлаждение и инфраструктуру

- Лицензии на ПО

- Техническую поддержку и обслуживание

- Обновления и модернизацию

Эти затраты могут в несколько раз превышать начальные инвестиции на горизонте 3-5 лет.

Если у вас остались вопросы по подбору конфигурации gpu сервера для machine learning или серверов для искусственного интеллекта — обращайтесь! Мы поможем найти решение, которое идеально соответствует вашим задачам и бюджету.